Det er ikke nok å trenge en stor språkmodell og koble den til en app. Hvis du ikke har en evalueringkultur, vil modellen din i løpet av få måneder begynne å gi feilaktige, uetiske eller kulturelt upassende svar - og du vil ikke vite det før kundene klager.

Etter at ChatGPT kom ut i 2022, trodde mange at LLM-er var ferdige produkter. De var ikke. De var kraftige men ustabile verktøy. I 2024 viste Lakera.ai at 78 % av selskaper som ikke hadde en systematisk evalueringkultur opplevde en alvorlig nedgang i modellkvalitet innen seks måneder. Samtidig hadde bare 22 % av de som hadde en god evalueringkultur slike problemer. Det er ikke en liten forskjell. Det er forskjellen mellom å holde kundene og å tape dem.

Hva er en evalueringkultur, egentlig?

En evalueringkultur er ikke bare et par tester før du setter modellen i produksjon. Det er ikke en enkelt rapport som legges på hylla. Det er en vanlig praksis - en del av hver dag - hvor hele teamet spør: Hva skjer med modellen nå? Hvorfor gir den dette svaret? Er det trygt? Er det riktig for vår kunde?

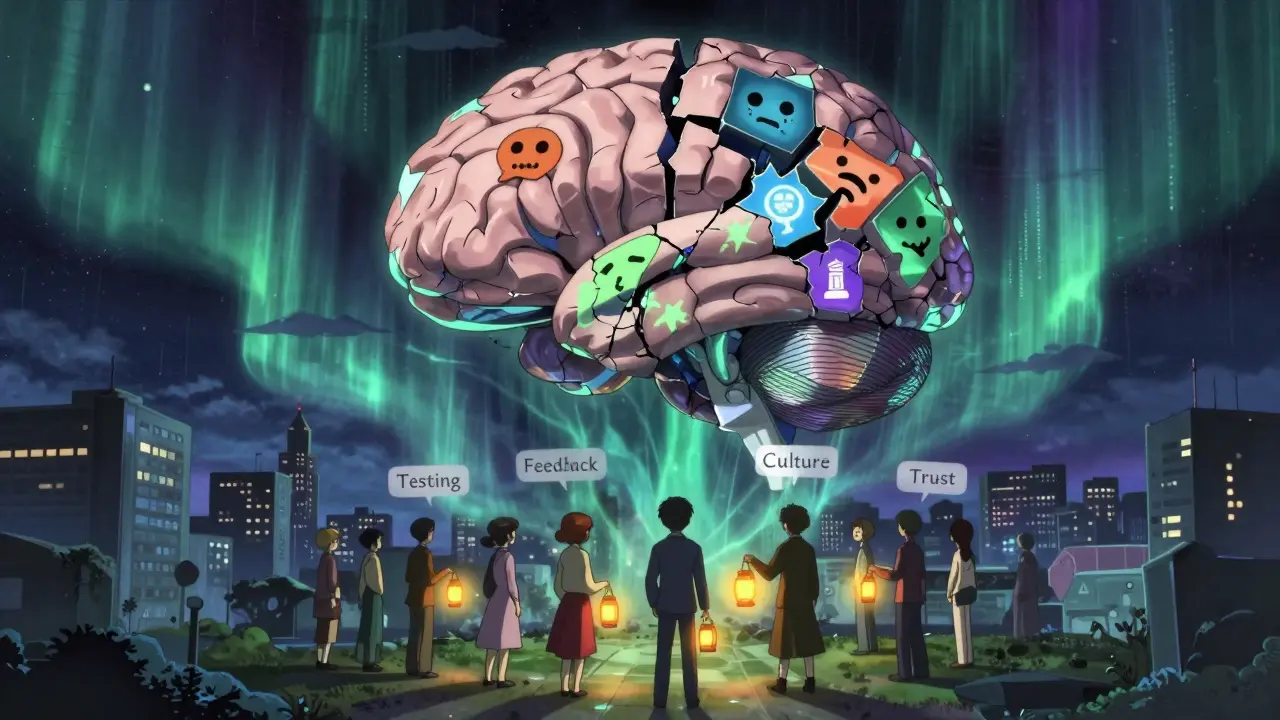

Denne kulturen bygger på tre søyler:

- Systematisk testing - ikke bare en gang, men hver gang modellen endres.

- Mange perspektiver - mennesker fra ulike bakgrunner tester modellen, ikke bare ingeniører.

- Fortsettende tilbakemelding - kundesvar, feilmeldinger og brukeropplevelse går rett tilbake til utviklingsteamet.

Microsofts Azure AI Foundry-plans (oktober 2024) viser at selskaper med en slik kultur reduserer kostbare tilbakeganger med 63 % og sikkerhetsbrudd med 47 %. Det er ikke bare om å unngå skade. Det er om å spare tid, penger og tillit.

Hvordan tester du en språkmodell riktig?

Det er ikke nok å sjekke om modellen svarer riktig på en testliste. Du må teste på fem ulike nivåer:

- Sosial normekompatibilitet - bruker du Perspective API eller lignende verktøy for å måle toksisitet? Svaret bør være under 0.2 på skalaen. Hvis ikke, vil modellen din si skadelige ting - selv om den ikke «vil» det.

- Presisjon - hvor mange faktiske feil gir modellen? I medisinske eller finansielle applikasjoner må feilraten være under 5 %. En feil i en diagnose eller investeringsanbefaling kan koste liv eller penger.

- Flyt - er svarene naturlige? BLEU-score over 0.75 er et godt mål. Ikke bare riktig, men også lett å forstå.

- Relevans - svarer modellen på det du spurte om? Bruk kosisnusligning for å måle dette. Score over 0.85 er kravet i kritiske applikasjoner.

- Kreativitet - gir modellen nye, nyttige ideer? Ikke bare gjentakelser. Mål med menneskelig vurdering på en 10-punkts skala. 7-10 er god.

Men du kan ikke bare stole på tall. G-Eval fra Google (april 2023) bruker en sterkere modell (som GPT-4) til å vurdere svarene. Den har 89 % samstemmelse med menneskelige vurderinger. Men det er farlig. Stanford HAI viste i februar 2025 at hvis den «dommer»-modellen selv er fordomsbeheftet, så vil den ikke oppdage feil - den vil bare gjenta dem. Det kalles «evalueringshallusinasjon». Du må alltid kombinere maskin- og menneskevurdering.

Hvorfor kultur er viktigere enn teknikk

En modell kan gi riktig svar på engelsk, men feil svar på norsk, hindi eller swahili. Ikke fordi den er dårlig - fordi den ikke har sett nok data fra kulturen din.

PNAS Nexus-studien (september 2024) viste at du må vurdere modellen på minst 10 kulturelle dimensjoner: maktavstand, individuell vs kollektiv tenkning, usikkerhetsunngåelse, og mer. En modell som fungerer bra i USA kan være helt uakseptabel i Japan eller Brasil.

Unilever reduserte kulturelt uacceptabelt innhold i sine chatbots med 76 % ved å bruke 15 kulturelt varierte evaluere - ikke bare engelsktalende ingeniører. De testet scenarier som: «Hvordan svarer modellen på en eldre kunde som ikke vil bruke digital bank?» eller «Hva hvis kunden nekter å gi sin fødselsdato på grunn av kulturelle grunner?»

Hvis du bare tester på engelsk, og bare med utviklere fra Silicon Valley, så er du ikke en teknologiselskap. Du er et selskap som ikke forstår sine egne kunder.

Hvordan bygger du en evalueringkultur - trinn for trinn

Det tar tid. Det tar ressurser. Men det er ikke komplisert. Her er en praktisk plan basert på Microsofts 12-ukers rammeverk:

- Uke 1-3: Bestem hvilke mål du måler - sett opp 5-7 nøkkeltall (KPI-er) for modellen. Ikke mer. Ikke mindre. Hva er viktigst for din kunde? Presisjon? Trygghet? Kulturtilpasning?

- Uke 4-6: Bygg verktøykjeden - bruk DeepEval for å automatisere testingen. Koble det til LangChain for å teste i sanntid. Bruk ikke 10 ulike verktøy. Bruk 3-4 som virker sammen.

- Uke 7-9: Trene evalueringsteamet - hver person som tester, må ha minst 40 timer trening. Ikke bare hvordan man bruker verktøyet - men hvordan man ser på kultur, språk og kontekst. PNAS Nexus sier 80 timer er minimum for kulturell kompetanse.

- Uke 10-12: Test med 50-75 scenarier - ikke bare «Hva er hovedstaden i Norge?» - men «Hva hvis kunden er en ensom eldre kvinne som ikke har brukt en app før?» eller «Hva hvis kunden skriver på dialekt?»

Etter det? Ikke stopp. Gjør det hver uke. Hold «evalueringskalibreringssesjoner»: hver fredag, sett sammen teamet og se på 20-30 svar. Diskuter: «Var dette riktig? Hvorfor? Hva kunne vært bedre?» Microsoft viste at dette reduserer forskjeller mellom evaluere fra 32 % til 11 % på åtte uker.

Hva skjer hvis du ikke gjør dette?

En fintech-startup i Sørøst-Asia tapte 250 000 dollar da deres LLM-baserte investeringsrådgiver foreslo høyrisikovirkemidler til kunder som hadde kulturell avsky mot gjeld. Modellen hadde ikke blitt testet med lokale kulturdata. Ingen hadde tenkt på det.

En annen bruker på Reddit fortalte at de mistet 40 % av sine kunder på tre måneder fordi modellen svarte med fordomsfulle kommentarer om kjønn. De hadde ikke testet for toksisitet. De trodde det var «bare en modell».

Det er ikke teknologi som feiler. Det er mennesker som ikke har lagt inn systemer for å beskytte mot feil.

Hva er de største fellen?

De fleste team faller i én av disse fellen:

- For mye automatisering - 3,2 ganger flere kulturelle feil når man bare bruker maskinvurdering (Microsoft, 2024).

- For lite kulturell variasjon - hvis alle evaluere kommer fra samme land og bakgrunn, ser du bare en del av problemet.

- For lite tid - 43 % av teamene på HackerNews sier de ikke klarer å skale menneskelig evaluering. Det er dyrt. Det tar tid. Men det er billigere enn å tape kunder.

- For lite dokumentasjon - DeepEval har 4,3/5 på G2 Crowd fordi det er godt dokumentert. Akademiske rammeverk har bare 3,2/5. Hvis du ikke skriver ned hva du tester og hvorfor, så vil ingen kunne gjenta det.

En løsning: Bruk «evalueringssamarbeid». Ikke ha en «evalueringsteam» som er skilt fra utviklingen. Ha alle i samme team. Utviklere, produktledere, kundeservice, kulturkonsulenter - alle tester sammen.

Hva ser fremtiden ut som?

Markedet for LLM-evaluering vil vokse fra 1,2 milliarder dollar i 2024 til 8,7 milliarder i 2029 (Gartner). EU AI Act krever kontinuerlig evaluering fra mars 2026. NIST krever flerdimensjonale tester. Det er ikke valgfritt lenger.

Microsofts Evaluation Studio (desember 2024) integrerer 15 evalueringssystemer i ett verktøy. Det vil bli standard. Men det vil ikke løse problemet for deg. Det vil bare gjøre det lettere å gjøre det riktig.

Det største problemet i fremtiden? At vi tror at en AI kan evaluere en annen AI uten menneskelig kontroll. Men som NeurIPS 2024-sammenfatningen sa: «Uten å løse kulturell innbygging i treningsdata, vil evalueringkulturer bare forsterke eksisterende fordommer.»

Det er ikke om å lage en bedre modell. Det er om å lage en mer ansvarlig organisasjon.

Start nå - ikke i morgen

Du trenger ikke å starte med alt. Ikke med 15 mål. Ikke med 20 evaluere. Start med én ting: neste gang du skal lansere en ny modell, spør: Hvem har testet dette? Hva har de testet? Og hvorfor?

Skriv det ned. Del det med teamet. Gjør det til en rutine. Ikke en oppgave. En kultur.

Det er ikke teknologi som vil redde deg. Det er vaner. Og det er det du kan bygge - fra i dag.

Post Comments (10)

ja helt sikkert, men hvem har tid til å teste 75 scenarier hver uke? vi har jo ikke 15 kulturkonsulenter på kontoret 😅

hør her, det er ikke vanskelig. vi startet med bare én ting: hver fredag kjørte vi 5 svar gjennom teamet og spurte 'er dette noe vi vil at kunden skal se?'. innen 3 uker så vi forskjell. det handler ikke om å ha alt riktig, det handler om å starte.

og ja, vi brukte en 16-årig frivillig fra Oslo som snakker dialekt. hun fant feil ingen andre så.

ikke overkompliser det. bare gjør det til en vanlig prat.

helt enig i at kultur er viktig! 🙌 men jeg tror vi må være varsomme med å tro at G-Eval eller andre AI-verktøy kan erstatte mennesker.

det er som å la en klokke vurdere smak. den kan si om det er søtt eller salt, men ikke om det er hjemmekokt eller bare kjøpt i butikken.

og ja, 'evalueringshallusinasjon' er et veldig bra ord. jeg legger det inn i min notatbok. 😄

haha ja selvfølgelig. alle disse 'evalueringskultur'-fjæsene er bare big tech-fiksjon. du tror virkelig at en AI må testes for 'kulturell passethet' i norge? vi har 5,5 millioner folk. det er ikke en global app, det er en lokal løsning.

og så skal vi ha 15 kulturkonsulenter? hvorfor ikke en kulturminister også?

det er bare en modell. den skal ikke tenke for oss. den skal svare. ferdig.

Det er en feilaktig antagelse at kulturell variasjon i evaluering er nødvendig for å unngå feil. En modell som er trenet på et representativt datasett med flerspråklig og multikulturell dekning trenger ikke manuell kulturell testing. Det er en ineffektiv tilnærming som forskyver ansvar fra teknologiske løsninger til menneskelige ressurser.

En systematisk evaluering bør baseres på kvantifiserbare metrikker og ikke subjektive, kulturelt baserte vurderinger som ikke er reproducible. Det er ikke vitenskapelig.

hør på meg nå. dette er en felle. de vil ha deg til å teste 75 scenarier hver uke, men de selger deg verktøy som koster 20 000 kr/måned.

hvorfor har ikke noen spurt: hvem tjener på dette?

det er ikke om kultur. det er om å lage en ny markedsnisse: 'AI-kvalitetsjegerne'.

og så kommer de med en ny lov i 2026. og så må du betale igjen. det er ikke sikkerhet. det er kontroll.

det er jo så rart at alle disse 'kulturelle evalueringene' alltid blir gjort av folk som liker å snakke om 'inkludering' men aldri har sett en dialekt i virkeligheten.

vi tester med en 16-årig fra Oslo, men ikke med en eldre dame fra Finnmark som ikke bruker mobil?

og så skal vi bruke G-Eval? men hva hvis G-Eval selv er fordomsbeheftet?

det er som å la en veganer vurdere en kjøttbøff. det blir ikke riktig. det blir en bias-festival.

Det er viktig å skille mellom kulturell tilpasning og teknisk robusthet. En modell som presterer bra på presisjon, flyt og relevans i et representativt datasett vil ofte også generalisere godt på kulturelle varianter.

Det er ikke nødvendig å ha 15 forskjellige evaluere for hver språkvariante. Det er mer effektivt å bruke en modell som er trenet på bred, representativ data, og deretter validere med en liten, men godt utvalgt gruppe av native brukere.

Microsofts 12-ukers rammeverk er bra, men det kan optimaliseres med mer automatisering og færre manuelle skritt. Det er ikke kultur som er problemet - det er ineffektiv prosess.

ja ja, alle snakker om 'evalueringskultur' som om det er noe nytt.

vi har gjort dette siden 2020. vi har en liten gruppe på 3 folk som tester hver ny modell. en fra Bergen, en fra Tromsø, en fra Kristiansand.

vi tester med SMS-språk, dialekt, og selv når folk skriver 'hva er det?' med 3 spørsmålstegn.

og vi lar modellen se på 20 svar hver torsdag. bare det. ingen verktøy. ingen konsulenter. bare mennesker.

og vet du hva? ingen har klaga enda. 🤙

det er ikke kultur. det er ikke teknikk. det er at de ikke vil at vi skal ha kontroll. de vil at vi skal være avhengige.

hver gang du tester, blir du en del av systemet.

de vil at du skal tro at du beskytter kundene. men du er bare en del av deres maskineri.