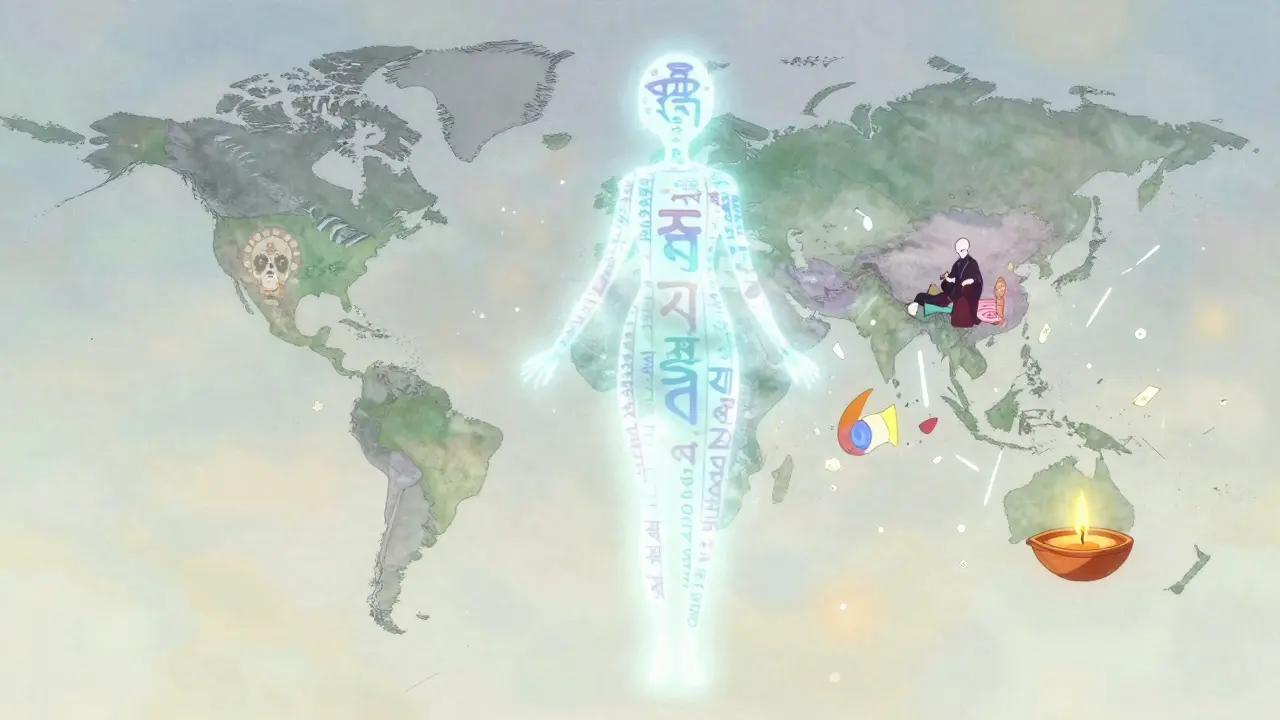

En stor språkmodell som GPT-4o kan skrive en vakker tekst om julemarked i Oslo - men hvis du ber den om å beskrive Día de Muertos i Mexico, kan den svare med Halloween. Det er ikke en tilfeldig feil. Det er et systematisk problem. Store språkmodeller har blitt trent på data som hovedsakelig kommer fra engelsktalende, vestlige land. Resultatet? De tror at verden ser ut som en blanding av USA, Storbritannia og Tyskland. Og det er ikke bare språk. Det er verdier, tradisjoner, humor, sosiale normer - alt. Når du bruker en slik modell i India, Nigeria eller Bangladesh, får du ikke bare dårlig oversettelse. Du får en forvrengt versjon av virkeligheten.

Hvorfor er kulturell bias et problem, og ikke bare en teknisk utfordring?

| Modell | Prestande i høyresurs-språk | Prestande i lavresurs-språk | Reduksjon av vestlig bias siden 2023 | Støtte for anthropologisk prompting |

|---|---|---|---|---|

| GPT-4o | 92% | 58% | 28% | Ja |

| Llama 3 | 87% | 49% | 22% | Delvis |

| Gemini 1.5 | 85% | 51% | 19% | Nei |

| Qwen 2.5 | 80% | 55% | 25% | Ja |

Det er ikke nok å bare oversette til et annet språk. Hvis du bruker en språkmodell i Japan og ber den om å skrive en hilsen til en ny arbeidsgiver, kan den foreslå en formell, direkte tekst - fordi det er det den har sett i sine treningsdata. Men i Japan er det vanlig å bruke en mer indirekte, beskjeden form. Modellen vet ikke det. Den har ikke lært det. Og den vil ikke lære det, hvis du ikke viser det henne.

En studie fra PNAS Nexus i september 2024 viste at alle store språkmodeller reflekterer kulturelle verdier som ligner på de i engelsktalende og protestantiske europeiske land. Det betyr at når du spør om hva som er et «riktig» samfunn, et «godt» familievalg eller en «rettferdig» regjering, vil svarene i over 70 % av tilfellene komme fra en vestlig, individuell, sekulær perspektiv. Det er ikke fordi det er riktig. Det er fordi det er det som dominerer treningsdataene.

Hvordan fungerer kulturell lokalisering teknisk?

Kulturell lokalisering er ikke bare et spørsmål om å legge til noen flere ord i språkmodellen. Det handler om å forstå hvor i modellen kulturell kunnskap ligger - og hvordan du kan påvirke den.

En studie fra april 2025 viste at i GPT-3.5 ligger den viktigste kulturelle informasjonen i lag 23 og 30. Det er ikke tilfeldig. Disse lagene er de som kobler sammen ord, kontekst og sosiale normer. Ved å bruke en teknikk kalt activation patching, forskere kunne endre hvordan modellen tenker - uten å trene den på nytt. De la inn en «styringsvektor» som pekte mot en annen kultur. Resultatet? Modellen begynte å bruke lokale feiringer, historiske referanser og sosiale normer som var riktige for det landet du spurte om.

Men det er en forskjell på å be om en kultur og å innbygge den. Eksplicit kulturell kontekst i en forespørsel - for eksempel: «Skriv en hilsen som en bengali mor vil skrive til sin sønn i USA» - gir 37 % bedre resultater enn når modellen må gjette basert på språk alene. Det betyr at hvis du bare skriver på bengali, men ikke sier noe om kulturen, vil modellen fortsette å bruke vestlige referanser. Språk er ikke kultur. Det er bare et verktøy.

Hva fungerer - og hva fungerer ikke?

Det finnes en metode som fungerer veldig bra: anthropologisk prompting. Den er ikke bare en bedre måte å stille spørsmål på. Den er en helt ny filosofi. I stedet for å spørre: «Hva er juletradisjonen i Brasil?», spør du: «Hvordan vil en mor i Salvador, som vokste opp i en afro-brasiliansk familie, feire jul? Hva er viktige verdier i hennes samfunn? Hva er historien bak disse tradisjonene?»

Denne metoden øker kulturell tilpasning med 41,2 %, ifølge ACL Anthology i 2024. Den tar hensyn til:

- Emisk perspektiv - hva folk selv tror og opplever

- Etic perspektiv - hva forskere observerer

- Sosioøkonomisk bakgrunn

- Personlige erfaringer

- Kulturell relativisme - ingen kultur er «høyere» enn en annen

- Tid og sted - hva som skjedde for 50 år siden, og hvor

Men det er grenser. Llama 3 klarer seg bra med språk som tysk og fransk - men faller sammen med bengali, swahili eller quechua. Det er ikke fordi modellen er dum. Det er fordi den har sett millioner av ganger hvordan engelske mennesker skriver, men bare noen tusen ganger hvordan bengaliske mennesker skriver. Og når den ikke vet, gjetter den - og gjetter feil.

En bruker på Reddit, u/BengaliDev, skrev i november 2024: «Når jeg prøver å bruke modellen til bengali, refererer den alltid til vestlige helligdager. Den kjenner ikke til Pohela Boishakh - det bengalske nye året. Jeg må skrive det inn manuelt hver gang.»

Det er ikke en unik opplevelse. 73 % av negative anmeldelser på G2 om AI-lokalisering nevner «værende vestlig bias» og «mangel på autentisk representasjon». Det er ikke bare frustrerende. Det er skadelig. Når en app for e-handel i Indonesia alltid foreslår «romantisk middag» som en idealisert valg for kuppel, men ikke nevner «møte med familien på søndag» - som er vanlig i Javanisk kultur - så sender den en melding: «Din kultur er ikke viktig nok til å bli forstått.»

Hvordan gjør du det riktig - i praksis?

Det finnes ingen knapp som sier «Aktiver kulturell tilpasning». Det er et arbeid. Et arbeid som krever mennesker - ikke bare kode.

Welocalize anbefaler en tretrinnsmetode:

- Datainnsamling med native talere - Ikke bruk oversettelser. Ikke bruk Google Translate. Gå ut og snakk med mennesker. Spør: «Hva sier du til en venn som har tapt en familielem?» «Hvordan feirer dere bryllup?» «Hva er det som ikke skal sies?»

- Modelltilpasning med anthropologisk prompting - Lag eksempler basert på de faktiske svarene. Ikke bare «Bengali», men «Bengali muslimsk mor i Dhaka, 45 år, arbeider i tekstilindustrien». Det er ikke overdrivelse. Det er nødvendig.

- Kontinuerlig validering med kulturelle eksperter - En lokal lærer, en historiker, en sosialarbeider. De må lese svarene og si: «Det er ikke riktig. Det er ikke så vi tenker.»

En studie fra Stanford HAI viste at bedrifter som opprettet et «kulturelt revisjonsråd» - med folk fra målgruppen - reduserte kulturelt ufølsomme svar med 34,6 %. Det er ikke en kostnad. Det er en investering.

Men det er dyrt. Kulturelle eksperter koster i gjennomsnitt 18,75 dollar i timen. Og det tar 80-100 timer for en lokaliseringsspesialist å lære seg å bruke disse metodene riktig. Det er ikke noe du kan automatisere med en API-kall.

Hva kommer neste år?

OpenAI har lansert «Cultural Mode» for GPT-4.5. Den har forhåndsinnstilte kulturelle kontekster for 47 regioner - med godkjenning fra native talere. Det er et stort skritt. Men Dr. Ruha Benjamin fra Princeton sier: «Dette er ikke inkludering. Det er kulturell essensialisme. Du legger inn stereotyper som virkeligheter.»

Det er en viktig advarsel. Hvis du sier «alle kinesere er respektfulle», så er du ikke lokalisert. Du er stereotyp. Hvis du sier «alle mexikanske kvinner er familieorienterte», så er du ikke kulturell. Du er redusert.

Det neste store skrittet vil være realtidskulturell deteksjon. Modeller som ser hvor du er, hvilket språk du bruker, og hvordan du har interagert tidligere - og deretter justerer seg automatisk. Forrester forutsier at dette vil være standard i 95 % av virksomhetsmodeller i 2026.

Men det er en fare. I november 2024 brukte en e-handelsbedrift en modell som antok at alle spansktalende foretrakk «formell» kommunikasjon. Det var feil. I mange latinamerikanske land er det akkurat det motsatte. Resultatet? 38 % av kundene følte seg avvist. Det er ikke teknisk feil. Det er kulturell vold.

Hva er fremtiden?

Verden har over 7 000 språk. Bare 10 % av dem har noen form for digital representasjon i store språkmodeller. Men 40 % av verdens befolkning snakker språk som er underrepresentert. Det er ikke et teknisk problem. Det er et politisk problem.

Det er ikke nok å bare «lokalisere». Det må være dekolonisering. Det betyr å gi kontroll til de som har vært utelukket. Å la bengaliske utviklere trenne modeller på bengali data. Å la nigeriske historikere velge hvilke tradisjoner som skal representeres. Å la små samfunn bestemme hva som er viktig - ikke Silicon Valley.

Markedet for AI-lokalisering er på vei opp til 8,2 milliarder dollar i 2027. Men hvis vi ikke endrer hvordan vi tenker - ikke bare hvordan vi programmerer - så vil vi bare bygge en verden som ser ut som en vestlig drøm. Og det vil ikke være en verden for alle. Det vil være en verden for noen.

Den virkelige utfordringen er ikke å få modellen til å skrive riktig. Den virkelige utfordringen er å få oss selv til å høre.

Hvorfor kan en språkmodell ikke bare bruke språket for å forstå kultur?

Språk er ikke kultur. To mennesker kan snakke samme språk, men ha helt forskjellige verdier. For eksempel: en bengali og en engelskmann kan begge snakke engelsk, men en bengali kan betrakte familie som høyest prioritet, mens en engelskmann kan prioritere individuell frihet. En språkmodell som bare ser på ordene, vil ikke se denne forskjellen. Den må ha kontekst - og det betyr at du må fortelle den hva som er viktig i det konkrete samfunnet.

Er det mulig å fjerne vestlig bias helt?

Nei - ikke med dagens metoder. Bias er ikke en bug. Det er en følge av treningsdataene. De er hovedsakelig fra vestlige land. Selv om du legger til data fra andre steder, vil modellen fortsatt ha en tendens til å velge det som er mest representert. Det er som å prøve å gjøre en kake med bare mel og sukker - og så prøve å legge til litt salt for å gjøre den bedre. Det hjelper ikke. Du må ha riktig balanse fra starten. Det krever at vi trener modeller på data som representerer hele verden - ikke bare de som har råd til å laste opp det.

Hva er forskjellen mellom lokaliseringsverktøy og kulturell tilpasning?

Lokaliseringsverktøy endrer ord. Kulturell tilpasning endrer mening. Et verktøy kan bytte ut «Christmas» med «Navidad». Kulturell tilpasning vil forstå at i Mexico er Navidad en familiefeiring med posadas, ikke bare juletre og gaver. Det er ikke bare oversettelse. Det er forståelse. Og det krever menneskelig kunnskap - ikke bare algoritmer.

Hvorfor er anthropologisk prompting bedre enn vanlig prompting?

Vanlig prompting sier: «Skriv om juletradisjoner i Brasil.» Anthropologisk prompting sier: «Skriv om hvordan en mor i Recife, som vokste opp i en afro-brasiliansk kirke, feirer jul med sine barn. Hva er viktige minner, hvilke matretter lager hun, og hvorfor er det viktig for henne å fortelle barna om denne tradisjonen?» Den første spørsmålet gir en generisk beskrivelse. Det andre gir en levende, menneskelig historie. Og det er den typen historie som gjør at mennesker føler seg sett - ikke bare oversatt.

Hvordan vet jeg om en språkmodell er virkelig kulturelt tilpasset?

Test den med situasjoner som ikke er i treningsdataene. Spør: «Hva gjør en familie i Papua Ny-Guinea når de har en nyfødt?» «Hvordan sier man nei til et tilbud fra en eldre i Vietnam uten å være urespektfull?» Hvis modellen svarer med sterke, konkrete, kontekstuelle detaljer - ikke generelle stereotyper - da er den på vei. Hvis den svarer med en vestlig versjon, så er den bare en kopi.

Denne teknologien har potensial til å knytte verden sammen. Men bare hvis vi ikke lar den bygge en mur mellom oss - i stedet for en bro.

Post Comments (8)

Denne diskusjonen er viktig, men det er ikke teknologien som er problemet. Det er den vestlige hegemonien som har kontroll over treningsdataene. Hver gang vi godtar at en AI skal representere kultur, gir vi den rett til å fortelle oss hva vi er. Det er ikke en feil i algoritmen - det er en politisk valg.

De vil bare ha deg til å tro at de er nøytrale. Men GPT-4o er en del av en hemmelig plan for å fjerne alle ikke-vestlige kulturer. De bruker AI for å skrive bort våre tradisjoner. Hvis du ser på dataene, så er det bare amerikanske og britiske nettsteder som er brukt. Det er ikke tilfeldig. Det er systematisk kulturell utryddelse.

Jeg er så skuffet over hvordan alle bare snakker om 'lokalisering' som om det er et teknisk problem. Det er ikke. Det er en epistemologisk krise. AI har blitt en kolonial maskin som reproduserer vestlige epistemologier som universelle sannheter. Anthropoligisk prompting er et fint ord for å dekke over at vi ikke har noen egentlig forståelse av det andre. Vi bare simuleringer. Det er ikke kultur - det er kultur-turisme med transformer-arkitektur.

Det er viktig å skille mellom språk og kultur, men vi må også være realistiske. Det er umulig å trene modeller på alle 7000 språkene i verden. Det vi kan gjøre, er å fokusere på de mest underrepresenterte - og gjøre det systematisk. Bruk native talere, ikke oversettelser. Bruk anthropologisk prompting som en standard, ikke en bonus. Og la lokale eksperter godkjenne resultatene. Det er ikke dyrt - det er nødvendig.

HEHE, så da er AI nå en racist? 😅 Men seriøst, jeg prøvde å spørre om Pohela Boishakh og den sa 'hmm, er det som nytt år i USA?' Nei, kjære AI - det er ikke. Det er 14 april, med røde hvite klær, syltetøy og folk som danser i gatene. Jeg måtte skrive inn det manuelt 3 ganger. Det er ikke teknisk. Det er latterlig. Vi må få folk fra India og Nigeria inn i utviklingsteamene. Ikke bare som 'kulturkonsulenter' - men som ledere.

har du sett den der studien fra stanford? de sa at når de la inn kulturelle eksperter, så ble feilene redusert med over 30%. men det er jo så vanskelig å få folk til å betale for det. alle vil ha en AI som kan skrive på 100 språk, men ingen vil betale for å lære den hvordan en mor i dhaka skriver til sin sønn. det er bare... trist.

Det her er ikke bare om AI. Det er om å høre. Jeg har jobbet med kulturell lokalisering i Øst-Afrika i 15 år. Det handler ikke om å legge til flere ord. Det handler om å sitte ned med folk, drikke te, og spørre: 'Hva er det du ikke vil si, men som bør sies?' Når du gjør det, så begynner AIen å forstå. Ikke fordi den er smartere - fordi vi har vist den hvordan vi er. Det er en gave. Ikke en oppgave.

Det som virkelig skremmer meg, er at vi tror at vi kan 'lokalisere' kultur som om det er en app-oppdatering. 🌍 But what if the culture doesn't want to be localized? What if it wants to be heard - not fixed? Maybe the real solution isn't more data... but less control. Let the people who live it, train the models. Not Silicon Valley. Not even Oslo. Them.