Gevir KI

- February 11, 2026

- Comments 0

- Teknologi og kunstig intelligens

Operasjonsmodell for innføring av LLM: Team, roller og ansvarsområder

En effektiv operasjonsmodell for LLM-er krever klare roller, teamstruktur og prosesser - ikke bare teknologi. Lær hvilke roller som er nødvendige, hvordan du bygger teamet, og hva som går galt i de fleste mislykkede implementeringer.

Read More

- February 9, 2026

- Comments 1

- Teknologi og kunstig intelligens

Konfidensiell computing for privat LLM-inferens: Slik beskytter du data og modeller

Konfidensiell computing lar store språkmodeller analysere sensitive data uten å se innholdet. Med hardvarebaserte sikre områder beskyttes både brukerdata og modellens egne vekter - og gjør AI-bruk i helse, finans og offentlig sektor mulig.

Read More

- February 8, 2026

- Comments 4

- Teknologi og kunstig intelligens

Komprimeringspipelines og verktøy for bedriftsbaserte LLM-team

Komprimering av store språkmodeller reduserer kostnader og forbruk med opptil 80 %, samtidig som den gjør AI tilgjengelig for edge-enheter og RAG-systemer. Her forklarer vi de fire teknikkene, verktøyene i 2026 og hvordan du starter.

Read More

- February 7, 2026

- Comments 3

- Teknologi og kunstig intelligens

Cyber sikkerhet og generativ AI: Trusselrapporter, spilleregler og simuleringer

Generativ AI har forandret cyber sikkerhet for alltid. I 2026 er angrep raskere, mer personlig og vanskeligere å oppdage. Denne artikkelen viser hva som skjer i virkeligheten, hvilke trusler som er farligst, og hvordan du beskytter deg.

Read More

- February 6, 2026

- Comments 5

- Teknologi og kunstig intelligens

RAG: Bedre søk og svar med generativ AI

RAG (Retrieval-Augmented Generation) forbedrer generativ AI ved å kombinere store språkmodeller med eksterne kunnskapsbasers. Den reduserer hallucinasjoner og gir mer nøyaktige svar. I 2026 er RAG en kritisk del av enterprise AI-stakken, med 82% av Fortune 500-selskaper som bruker den. Men implementeringen kan være utfordrende uten riktig ekspertise.

Read More

- February 5, 2026

- Comments 7

- Teknologi og kunstig intelligens

Balansert treningdatakuratur: Hvordan sikre rettferdighet i store språkmodeller

Balansert treningdatakuratur sikrer at store språkmodeller lærer fra jevnt representerte data. Dette reduserer bias og forbedrer ytelse. Metoder som ClusterClip og Google Active Learning har vist betydelige resultater. EU AI-loven krever nå dokumentasjon av balansert data. Framtiden ser ut til å inkludere dynamisk kuratur for bedre rettferdighet.

Read More

- February 4, 2026

- Comments 8

- Teknologi og kunstig intelligens

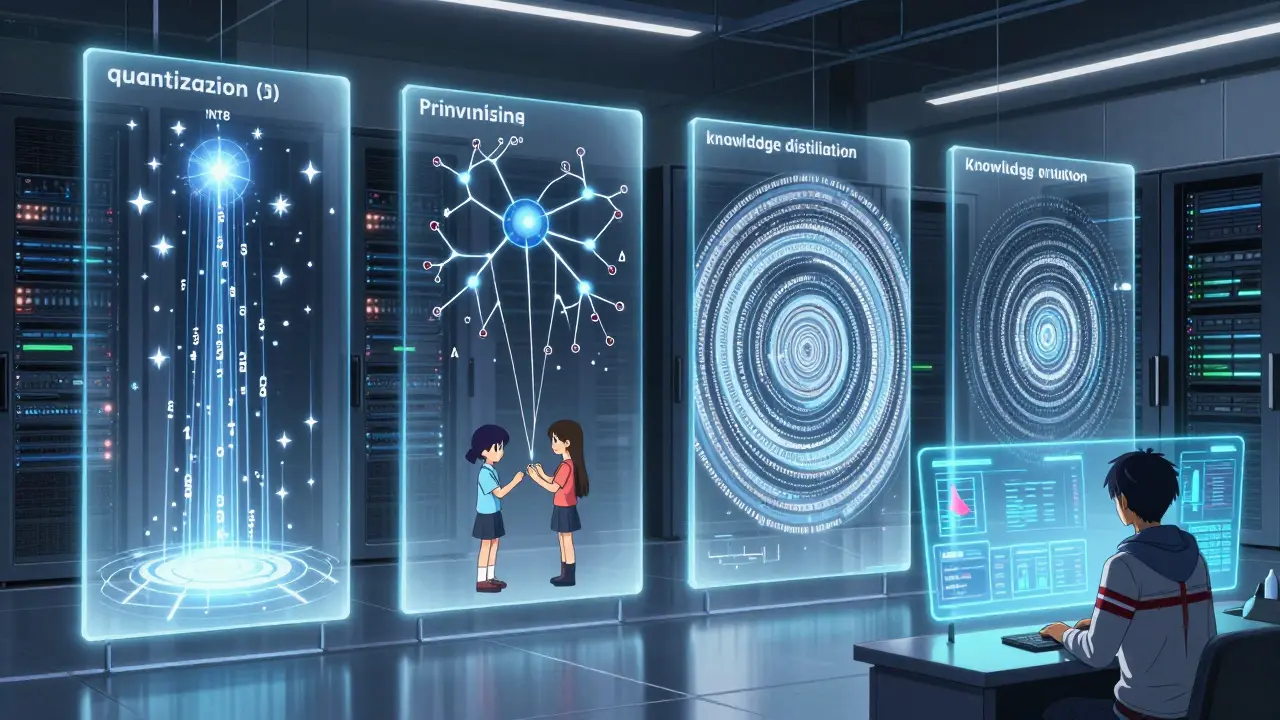

Kvantisering og distillasjon: Slik reduserer du kostnadene for store språkmodeller

Lær hvordan kvantisering og distillasjon kan redusere kostnadene for store språkmodeller med opptil 95%. Vi viser reelle eksempler, tekniske detaljer og beste praksis for å implementere disse teknikkene i produksjon.

Read More

- February 3, 2026

- Comments 6

- Teknologi og kunstig intelligens

Arkitektur-først prompt-maler for vibe-kodingssesjoner

Arkitektur-først prompt-maler hjelper deg å få produksjonsklar kode fra første forsøk. Lær hvordan du skriver prompter som gir sikker, vedlikeholdbar og riktig strukturert kode med AI-assistert koding.

Read More

- February 2, 2026

- Comments 8

- Teknologi og kunstig intelligens

Adapter-lag og LoRA for effektiv tilpasning av store språkmodeller

LoRA og adapter-lag lar deg tilpasse store språkmodeller med bare 1% av minnet. Lær hvordan disse teknikkene fungerer, når du skal velge dem, og hvordan du kommer i gang med en RTX 4090.

Read More

- February 1, 2026

- Comments 5

- Teknologi og kunstig intelligens

Spars og dynamisk ruting i store språkmodeller: Hvordan AI blir mer effektiv uten å bli større

Spars og dynamisk ruting i store språkmodeller lar AI-brukere få større kapasitet med mye lavere kostnad. MoE-arkitekturer som RouteSAE og Switch Transformer gjør det mulig å bruke trillioner av parametre uten å øke regnekostnaden dramatisk.

Read More

- January 30, 2026

- Comments 7

- Teknologi og kunstig intelligens

Executive Education on Generative AI: Boards, C-Suite, og Ledere i Bedrifter

Ledere må forstå generativ AI for å ikke bli bak. De beste utdanningsprogrammene gir strategisk kunnskap, ikke teknisk. 75 % av bedrifter bruker AI i 2026. Her er hvilke programmer som virker og hvordan du starter.

Read More

- January 29, 2026

- Comments 5

- Teknologi og kunstig intelligens

Contrastive Prompting for Reducing Hallucinations in Large Language Models

Contrastive prompting reduces hallucinations in AI models by comparing outputs under different prompts-without retraining. It's now used in healthcare, legal tech, and finance to improve factuality.

Read More