En AI som skriver en tekst, lager et bilde, eller beslutter hvem som får et lån - den ser ut til å tenke. Men den tenker ikke. Den repeterer. Og når den repeterer fordommer, skjer det ofte uten at noen ser det. I 2026 er det ikke lenger nok å bygge en AI som er rask eller smart. Det må være en AI som er ansvarlig.

Hva betyr ansvarlig AI?

Ansvarlig AI handler ikke om å holde seg til regler. Det handler om å bygge systemer som respekterer mennesker - ikke bare i teori, men i praksis. Når en generativ AI lager tekst, videoer eller bilder, så gjør den det basert på data den har lest gjennom år. Og den har lest mye av det samme: historiske fordommer, ulike maktstrukturer, og manglende representasjon. Resultatet? En AI som kan forsterke diskriminering, skape falske forestillinger, eller slette stemmer som allerede er svake.Det er ikke nok å si: "Vi har en etikk-kodeks." Hvis ingen har ansvar, ingen har råd til å stoppe det, og ingen sjekker om det virkelig fungerer - så er koden bare papir. Ansvarlig AI krever tre ting: rettferdighet, gjennomsiktighet, og ansvarlighet. Ikke bare som ord i en presentasjon, men som faste praksiser i hver eneste utviklingsrunde.

Hvorfor er fordommer et alvorlig problem i generative systemer?

En språkmodell som har lest millioner av nettsteder, bøker og forum, har også lest de mest fordomsfulle delene av menneskelig historie. Den har lest at menn er bedre ledere. At kvinner ikke er gode i teknologi. At folk med mørkere hudfarge er mer sannsynlig til å være kriminelle. Og når den lager svar, så gjør den det basert på det den har sett - ikke basert på hva som er rett.Det er ikke bare et problem med utvalg. Det er et problem med forsterkning. En AI kan lage en tekst som sier: "Den beste kandidaten for stillingen er en mann med en teknisk utdannelse." Og hvis denne teksten brukes til å rekruttere, så vil den fortsette å forsterke samme mønster - uansett om det er riktig eller ikke. Flere studier fra 2024-2025 har vist at generative modeller ofte produserer resultater som er 30-50% mer fordomsfulle enn treningsdataene de er bygget på.

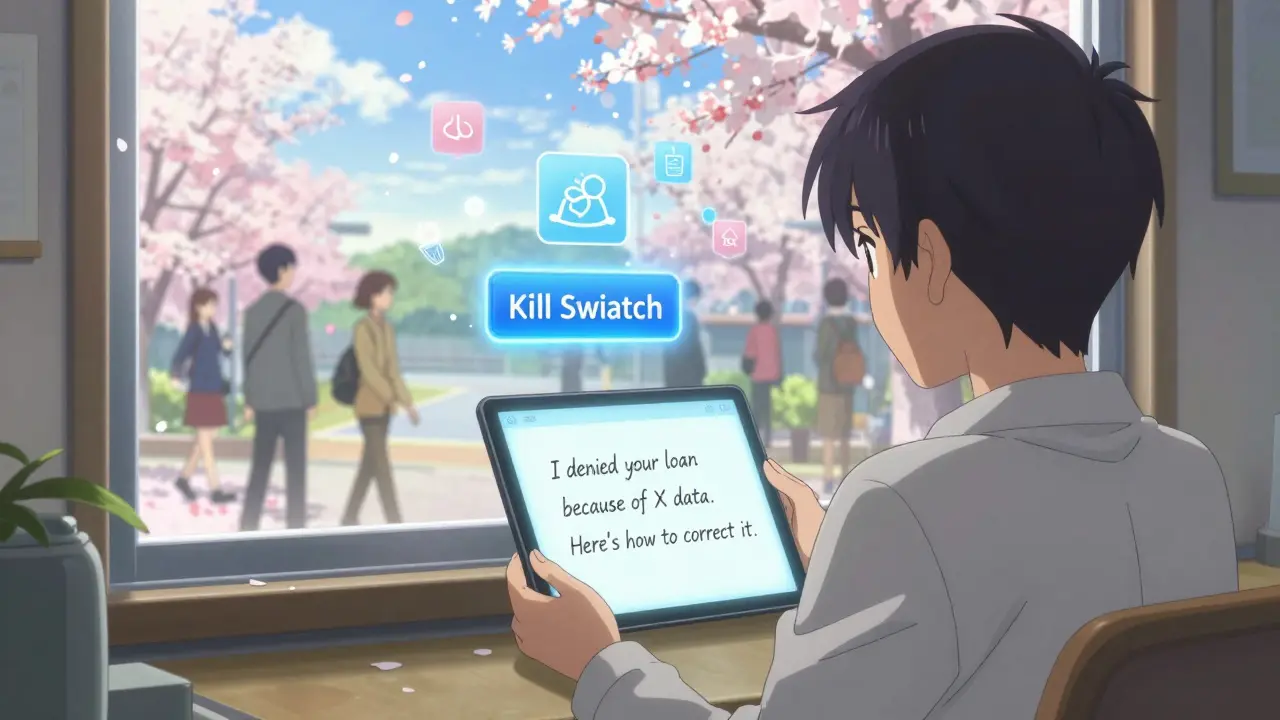

Løsningen er ikke å slette data. Det er umulig. Løsningen er å sjekke. Bruk verktøy som SHAP og LIME for å se hvilke ord, bilder eller data som påvirker en avgjørelse. Ikke bare i laboratoriet - men i virkeligheten. Når en AI avviser en lånepåstand, må den kunne forklare hvorfor. Ikke med teknisk jargon, men med en forklaring en vanlig person kan forstå.

Gjennomsiktighet er ikke et valg - det er en forutsetning

Hva skjer når en AI sier "nei"? Hva skjer når den sier "ja"? Hvis du ikke vet, så er du ikke i kontroll. Du er bare en bruker.For mange organisasjoner er gjennomsiktighet et problem. Det er lettere å si: "Det er en svart boks. Vi vet ikke hvordan den virker." Men det er ikke bare et teknisk problem - det er et etisk og juridisk problem. EU’s AI-lov, NIST sin rammeverk, og ISO 42001 krever nå tydelig dokumentasjon av alle AI-systemer. Hvor kom dataen fra? Hvordan ble modellen trent? Hva ble testet? Hva ble glemt?

En AI som ikke kan forklare seg selv, bør ikke brukes i viktige beslutninger. Ikke i helse, ikke i rettsvesenet, ikke i jobbutsending. Ikke i noensomhelst liv. Gjennomsiktighet betyr ikke at du må dele koden. Det betyr at du må kunne svare på: "Hvorfor?"

Ansvaret må ligge hos mennesker - ikke maskiner

En AI kan ikke bli dømt. Den kan ikke bli ansvarlig. Den kan ikke bli tvunget til å be om unnskyldning.Derfor må mennesker stå ansvarlig. Ikke en "Chief AI Ethics Officer" som bare sitter i et kontor og skriver rapporter. Men en teamstruktur der dataforskeren, juristen, etikeren og brukerrepresentanten har lik makt. Der det finnes en klar RACI-matrise: hvem er ansvarlig, ansvarlig, konsultert, og informert for hver AI-beslutning.

En "kill switch" er ikke science fiction. Den er en nødvendig sikkerhetsmekanisme. Hvis en AI begynner å produsere farlige innhold, må det være en knapp som kan trykkes - og noen som har myndighet til å trykke den. Ikke etter at det har skjedd. Ikke etter at noen har blitt skadet. Men før.

Det betyr også at ledere må ha sine lønninger knyttet til ansvarlig AI. Ikke bare til nøyaktighet eller hastighet. Men til hvor godt de har kontrollert fordommer, hvor godt de har forklart systemet, og hvor godt de har lyttet til brukere. Hvis du ikke måler det, så vil du ikke forbedre det.

Hvordan bygger man ansvarlig AI i praksis?

Det er ikke nok å lese en rapport. Du må bygge det inn i hver eneste steg:- Før utvikling: Gjør en etisk risikovurdering. Hvilke grupper kan bli skadet? Hvilke data er brukt? Er de representativt? Involver brukere fra ulike bakgrunner.

- Under utvikling: Legg inn verktøy for feilretting direkte i CI/CD-pipeline. Bruk bias-detection-verktøy som Aequitas eller IBM’s Fairness 360. Test ikke bare på data - test på virkelige brukere.

- Ved frigivelse: Gi brukere en forklaring. Ikke bare en "AI-brukeravtale". En forklaring i enkel språk: "Denne AI bruker data fra X og Y. Den kan feile på Z. Her er hvordan du kan rapportere feil."

- Eter frigivelse: Publiser årlige transparensrapporter. Fortell hva som gikk galt, hva du gjorde, og hva du vil gjøre neste år. Hør på brukerne. Endre. Ikke bare for å overholde loven - fordi det er riktig.

Det er ikke en prosess. Det er en kultur. Og den må starte på toppen. Hvis CEO-en ikke forstår at en AI som ikke forklarer seg selv er en risiko, så vil ingen annen gjøre det heller.

Hva sier loven? EU AI Act, NIST og ISO 42001

I 2026 er det ikke lenger valg om du skal følge regler. Det er et spørsmål om når du blir pålagt.EU’s AI-lov er den mest omfattende. Den deler AI-systemer i fire risikonivåer: ubrukelig, begrenset, høy og uakseptabel. Generative systemer som lager falske bilder eller stemmer faller under "høy risiko". Det betyr at de må ha dokumentasjon, testing, og menneskelig overvåking - ellers kan du ikke selge dem i Europa.

NIST AI Risk Management Framework gir en praktisk veileder: kartlegg risiko, overvåk, og juster. Det er ikke en standard - det er en metode. Og den fungerer for alle, uansett størrelse.

ISO 42001 er den første internasjonale standard for AI-governance. Den krever at organisasjoner har en AI-håndbok, en ansvarlig for etikk, og en prosess for å håndtere feil. Den er ikke en trussel. Den er en mulighet. Den som følger den, får tillit - og marked.

Hva er de nye målene for suksess?

Det er ikke lenger: "Hvor nøyaktig er modellen?"Det er: "Hvor mye tillit har brukerne?"

En AI med 15 milliarder parametre som ikke kan forklare hvorfor den nektet deg et lån - er verre enn en enkel modell som kan forklare seg. Det er ikke smart. Det er usikkert.

De nye KPI-ene er enkle:

- Hvor mange brukere har forstått hvorfor en AI-avgjørelse ble tatt?

- Hvor mange feil ble oppdaget før de kom ut i produksjon?

- Hvor mange ulike grupper har blitt involvert i testingen?

- Hvor ofte har systemet blitt stoppet av en menneskelig overvåkning?

Disse målene er ikke tekniske. De er menneskelige. Og de er de eneste som teller.

Hva kommer neste? 2027-2028 og videre

I 2027 vil vi ikke lenger spørre: "Er AI ansvarlig?"Vi vil spørre: "Hvorfor var den ikke det?"

Organisasjoner som har bygget ansvarlig AI nå - med virkelig strukturer, med mennesker i ledelsen, med åpenhet og tilbakekobling - vil være de eneste som overlever. De andre vil bli borte. Enten av loven, av brukerne, eller av sin egen uansvarlighet.

Det er ikke en teknisk utfordring. Det er en menneskelig valg. Vi kan bygge AI som forsterker vår beste side. Eller vi kan bygge AI som forsterker vår dårligste side. Det er ikke maskinen som bestemmer. Det er vi.

Hva er forskjellen mellom etikk og lovgivning i AI?

Etikk handler om hva som er riktig - selv om det ikke er lov. Lovgivning handler om hva som er lovlig - selv om det ikke er riktig. En AI kan være lovlig men uansvarlig. For eksempel: En AI som bruker data fra et land som ikke har datalovgivning - kan være lovlig i Norge, men uetisk. Ansvarlig AI krever begge deler: å følge loven og å gjøre det riktige.

Kan en AI virkelig være rettferdig?

Ja - men ikke uten menneskelig innsats. En AI kan ikke være rettferdig av seg selv. Den kan bare gjenta det den har lært. Rettferdighet må bygges inn gjennom valg: hvilke data vi bruker, hvem vi tester med, hvilke feil vi aksepterer, og hvem som har siste ord. Det er mennesker som bestemmer. AI bare utfører.

Hvorfor er diverse team viktig for ansvarlig AI?

En homogen gruppe ser bare sine egne fordommer. En diverse gruppe ser flere perspektiver - og dermed flere risikoer. En kvinne fra Nigeria, en eldre mann fra Svalbard, og en ikke-binær utvikler fra Filipinene vil se ulike problemer i samme AI-system. Hvis du bare har menn fra California, så vil du ikke se de fleste problemene. Mangfold er ikke et valg. Det er en sikkerhetsmekanisme.

Hva er en "kill switch" i AI?

En "kill switch" er en knapp - fysisk eller digital - som kan stoppe en AI i øyeblikket hvis den begynner å skape skade. Det kan være en AI som lager voldelige bilder, eller en som nekter tjenester til en hel gruppe mennesker. Den må være enkel å bruke, og det må være noen som har myndighet til å trykke den - uten å måtte vente på godkjenning. Den er ikke en farlig funksjon. Den er en nødvendig beskyttelse.

Hva skal en liten bedrift gjøre for å bli ansvarlig?

Du trenger ikke en stor etikk-avdeling. Du trenger tre ting: 1) Spør deg selv: "Hvem kan bli skadet?" 2) Bruk gratis verktøy som Google’s What-If Tool eller IBM’s Fairness 360 for å sjekke fordommer. 3) Skriv en enkel forklaring til brukerne: "Denne AI bruker X-data. Den kan feile på Y. Kontakt oss hvis du tror det skjedde." Det er mer enn mange store selskaper gjør.

Post Comments (1)

Denne posten er en mesterlig oversikt, men jeg må si: vi har sett dette før. 'Ansvarlig AI' er nå det nye 'sustainable' i marketing. Alle snakker om det, men ingen gjør det. Jeg jobber i en fintech og vi har en AI som avgjør lån - og ja, den er 40% mer fordomsfull mot kvinner enn treningsdataene viser. Men vi har ikke råd til å retrain den, så vi skjuler det bak 'statistisk signifikans'. Hva skal vi gjøre? 😅