Generativ AI ser ut som en ny teknologi, men dens røtter går tilbake til 1913, da den russiske matematikeren Andrey Markov lagde de første modellene for å forutsi neste element i en sekvens basert på hva som kom før. Det var ikke et program, ikke en datamaskin - bare en matematisk idé. Men den var nok til å legge grunnlaget for alt som kom etter: fra chatbottene på 1960-tallet til GPT-4 og Stable Diffusion i dag. Denne historien handler ikke om marketing, ikke om hype. Den handler om hvordan enkle sannsynlighetsmodeller ble til systemer som kan skrive romaner, lage bilder fra tekst, og selv tenke i trinn.

Markov-kjeder: Den første formen for generativ tenkning

Markov-kjeder fungerer enkelt: Hvis du har en sekvens av ord eller tegn, kan du beregne sannsynligheten for hva som kommer neste, bare ved å se på hva som har vært der før. Hvis teksten din ofte har ordet "hund" etter "hjemme", så vil modellen velge "hund" med høy sannsynlighet når den ser "hjemme". Det er ikke forståelse - det er statistikk. Men det var nok til å generere tekst som så ut som menneskelig. I 1950- og 60-tallet ble disse modellene brukt til å generere tale, og de var grunnlaget for de første språkmodellene. De var svake, men de var første skritt. Ingen tok dem alvorlig som "kunstig intelligens" - de var bare matematiske verktøy. Men de viste at maskiner kunne lage noe nytt, ikke bare analysere det som allerede eksisterte.

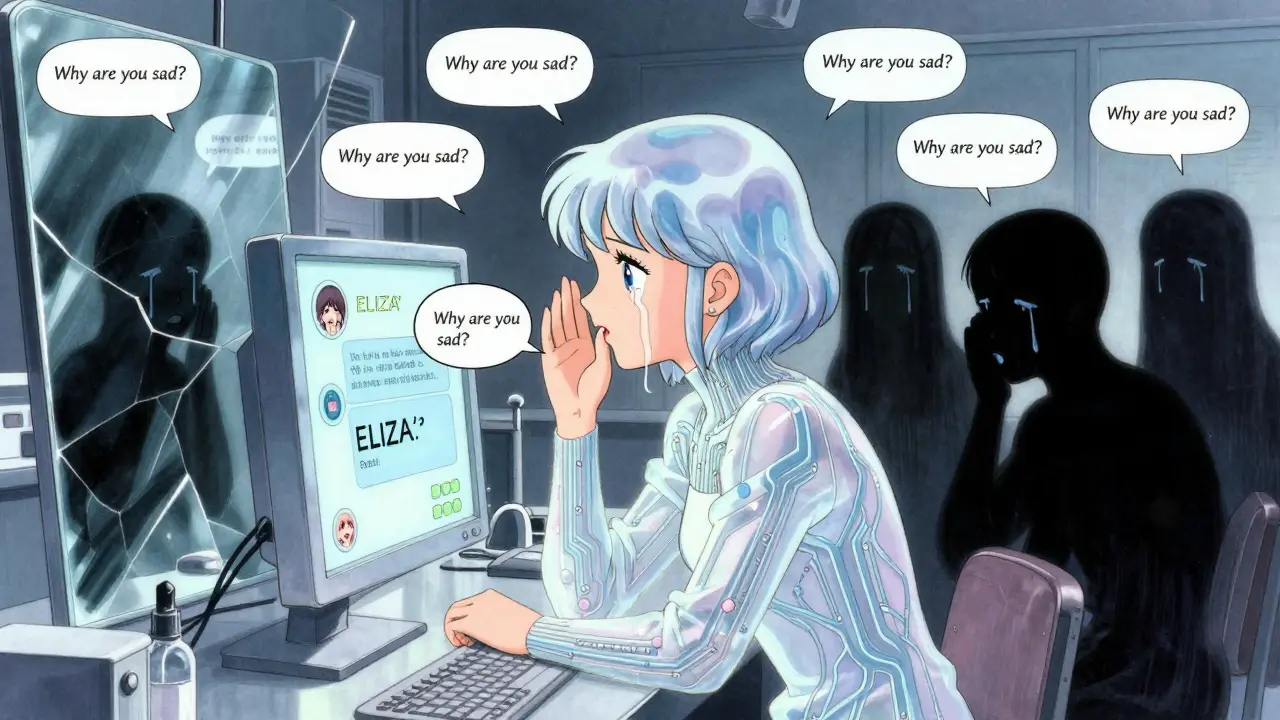

ELIZA og den første illusionen av forståelse

I 1964 lanserte Joseph Weizenbaum ELIZA, en chatbot som simulerte en psykolog ved å bruke enkle mønstermatchingsregler. Hvis du skrev "Jeg er trist", så svarte den "Hvorfor er du trist?" Det var ikke intelligens. Det var en liste med regler. Men mennesker reagerte som om den forsto dem. Dette ble kjent som "ELIZA-effekten" - vår evne til å se menneskelighet der den ikke finnes. Det var første gangen en datamaskin skapte en følelse av dialog. Det var også første gangen folk begynte å tro at AI kunne tenke. Det var en illusjon, men den var kraftig nok til å drive forskning videre.

Perseptroner, RNN-er og AI-vinteren

1958 kom Frank Rosenblatts perseptron - den første neurale nettverkmodellen som kunne lære fra data. Det var et gjennombrudd. Men det var begrenset. I 1982 ble Recurrent Neural Networks (RNN-er) laget. De kunne holde minne om tidligere inndata - noe Markov-modellene ikke kunne. Men de hadde et stort problem: de glemte. Hvis du hadde en tekst med 100 ord, så var de første ordene nesten uansett for det siste. Da kom Jürgen Schmidhuber i 1997 med LSTM (Long Short-Term Memory). Det var en forbedring som gjorde det mulig å huske informasjon over veldig lange sekvenser. LSTM-er ble brukt til talegjenkjenning, og i 2007 laget Schmidhubers team den første neurale talegjenkjenningssystemet som var bedre enn alle tidligere metoder. Det ble grunnlaget for Google Translate i 2016. Men selv med LSTM var det vanskelig å skale. De trengte tid - og de var treg. Da kom AI-vinteren: i 1970- og 1980-tallet ble forskningsmidler kuttet. Folk trodde AI ikke kunne levere. Det var ikke fordi teknologien var dårlig - det var fordi forventningene var for høye.

GAN-er, VAE-er og den nye genererende bølgen

2014 endret alt. Ian Goodfellow introduserte GAN-er (Generative Adversarial Networks). To nettverk kjempet mot hverandre: ett genererte bilder, og ett forsøkte å skille mellom sanne og falske. Det var som en falskmøntmaker mot en politibetjent. Når falskmøntmakeren ble bedre, ble politiet også bedre. Og snart var bildene så gode at mennesker ikke kunne skille dem fra virkelige. Samtidig ble VAE-er (Variational Autoencoders) brukt til å lage nye data ved å lage en "kode" for data og så generere nye varianter av den. Begge metodene viste at AI kunne lage noe nytt - ikke bare gjenkjenne. Men det var fremdeles vanskelig. GAN-er var ustabile. De kunne "kollapse" og lage bare kaos. De var kunstneriske, men ikke kontrollerbare.

Transformere: Når alle regler ble skrevet om

2017. Google publiserte artikkelen "Attention is All You Need". Den var enkelt. Den sa: Glem RNN-er. Glem LSTM-er. Bruk oppmerksomhet. Det var ikke en liten forbedring. Det var en revolusjon. I stedet for å gå gjennom et ord om gangen, så så transformermodellen på alle ordene samtidig. Den spørte: Hvilke ord er viktigst for å forstå dette? Den brukte "self-attention" - en mekanisme som lot modellen vurdere relasjoner mellom alle ord i en setning, uavhengig av avstand. Det betydde at den kunne forstå "Hun sa at han hadde tatt bilen, men han sa at han ikke hadde gjort det" - og forstå hvem som sa hva. Og den kunne gjøre det i sekunder, ikke timer. Det var O(n²) i minne, men med GPU-er som ble 100 ganger raskere, var det en god avveining. GPT-1 kom i 2018. GPT-2 i 2019 med 1,5 milliarder parametere. GPT-3 i 2020 med 175 milliarder. Det var ikke bare større - det var noe annet. De begynte å vise "emergent abilities": evner som ikke var programmert, men som dukket opp når modellen ble stor nok. De kunne skrive kode. Løse matematiske oppgaver. Skrive dikt. De kunne svare på spørsmål de aldri hadde sett før. Det var som om de hadde forståelse - selv om de bare gjorde statistikk på en gigantisk skala.

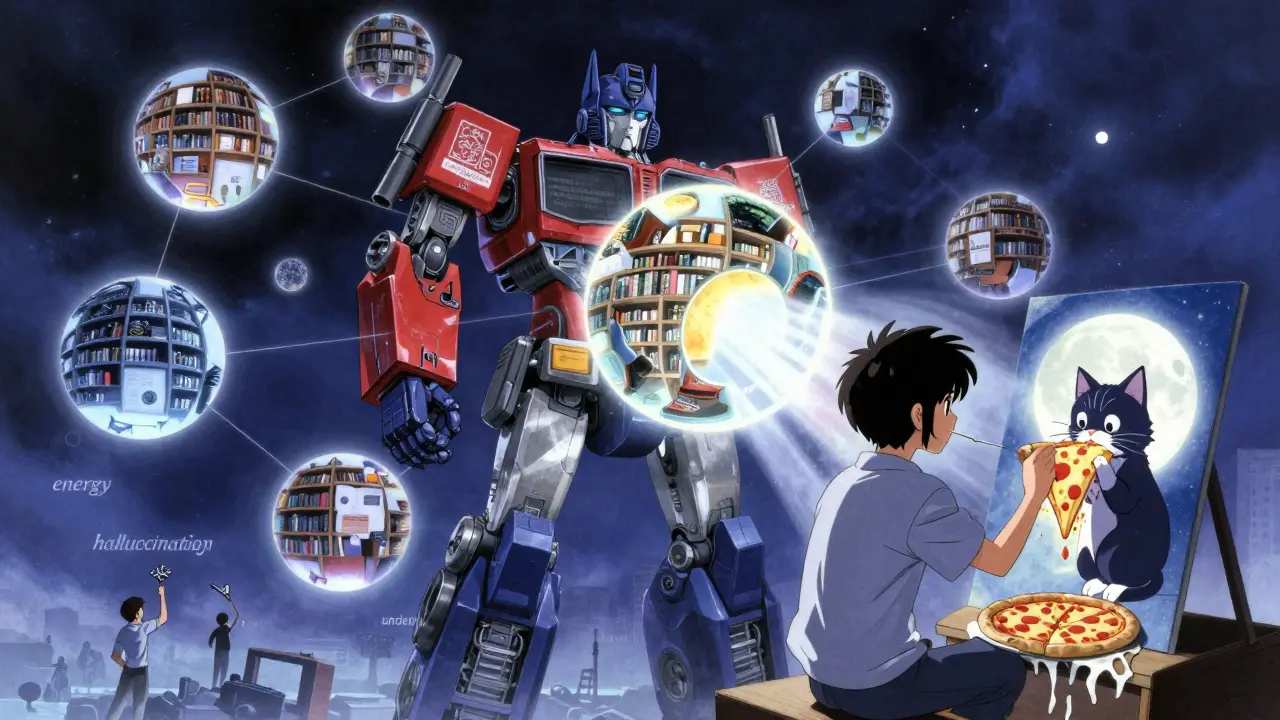

Transformere og multimodalitet: Fra tekst til bilder og tilbake

2021: DALL-E. Et transformermodell som tok en tekst som "en katt som spiser en pizza på månen" og laga et bilde. Ikke en collage. Ikke en montage. Et nytt bilde. Et bilde som aldri hadde eksistert før. Det var ikke bare tekst til bilde. Det var forståelse av sammenhenger. 2022: Stable Diffusion. Det kombinerte diffusjonsmodeller med transformerar. Det ble åpne kildekode. Og plutselig kunne enhver lage fotorealistiske bilder. Det var ikke lenger bare for Google og OpenAI. Det var for alle. Og det endret kultur. Kunstnere ble redd. Selskaper begynte å bruke det til reklame. Skoler lærte elever å bruke det. Men det var ikke perfekt. 43 % av brukere av Stable Diffusion rapporterte at de ikke kunne få samme karakter til å se lik ut i flere bilder. Det var et problem med konsistens - og det var et problem med hvordan transformermodeller lærer. De lærer mønstre, ikke objekter. De forstår ikke at en katt har fire bein. De lærer at katter ofte har fire bein i bilder de har sett.

Problemer som ikke går vekk

Transformere er kraftige, men de har alvorlige svakheter. De bruker enormt mye energi. Å trene GPT-3 krever omtrent 1 300 megawattimer - nok til å drive 120 hus i et år. De har kvadratisk minnebehov - hvis du dobler lengden på teksten, så bruker du fire ganger så mye minne. De kan ikke regne presist. De kan skrive en matematisk formel, men de kan ikke bevise den. De "hallusinerer" - de lager fakta som ikke eksisterer. Og de er sorte bokser. Ingen vet helt hvorfor de svarer som de gjør. Det er ikke en feil. Det er en egenskap. De er statistiske modeller - ikke logiske. De er ikke tenkende. De er etterlignende.

Hva kommer nå?

2023: Google lanserte Gemini - en multimodal modell som skal være bedre enn GPT-4. Microsoft lanserte Phi-2 - en modell med bare 2,7 milliarder parametere som presterer som GPT-3.5. Det betyr at vi ikke trenger større modeller - vi trenger smartere. 2024: DeepMind presenterte Mamba - en ny arkitektur som bruker "state-space modeling" for å unngå O(n²)-problemet. Det er en mulig etterfølger til transformers. Og det er ikke bare teknologi. Det er filosofi. Mange forskere tror at vi trenger noe annet enn transformers for å nå menneskelig intelligens. Vi trenger modeller som bygger opp verdensmodeller - ikke bare lærer mønstre. Vi trenger AI som forstår at en katt ikke bare er et mønster av pels og øyne - men et levende vesen med mål og følelser.

Det er ikke bare teknologi - det er mennesker

92 % av utviklere på Reddit sier de kan tilpasse transformermodeller til sine behov med liten tilpasning. Men 68 % sier de ikke forstår hvorfor modellen gir et svar. 57 % sier kostnaden er for høy. Og 73 % av selskaper måtte ombygge hele sine datapipler for å bruke det. Det er ikke bare en ny teknologi. Det er en ny måte å tenke på arbeid. Det er en ny måte å tenke på kreativitet. Og det er en ny måte å tenke på sannhet. Når en maskin kan skrive en nyhet som ikke er sant, men som lyder som sant - hva betyr det for demokrati? For kunst? For læring?

Det vi ser nå er ikke slutten. Det er starten. Fra en enkel matematisk ide til systemer som kan skape verden. Og vi står nå ved et punkt hvor vi må velge: Skal vi bruke dette til å forstørre menneskelig forståelse? Eller bare til å lage bedre illusioner?

Hva er forskjellen mellom Markov-modeller og transformers?

Markov-modeller forutsier neste element i en sekvens bare basert på et par tidligere elementer - de har ingen langtidsminne. Transformers ser på hele sekvensen samtidig og bruker oppmerksomhet til å finne ut hvilke deler som er viktigst. Det gjør dem mye mer kraftige for komplekse oppgaver som å skrive tekster eller forstå sammenhenger over flere setninger.

Hvorfor ble LSTM viktig for generativ AI?

LSTM-er var de første neurale nettverkene som kunne holde minne over lange sekvenser. Før dem glemte RNN-er allerede etter 5-10 ord. LSTM-er kunne huske informasjon over 100+ ord - noe som gjorde det mulig å bygge talegjenkjenning og oversettelsessystemer som virket. De var grunnlaget for alle senere sekvensmodeller, inkludert de første versjonene av GPT.

Hva gjør transformers bedre enn LSTM-er?

Transformers kan prosessere alle ord i en setning samtidig - de er parallelle. LSTM-er må gå gjennom hvert ord ett etter ett, som en linje av brikker. Det gjør transformers raskere og bedre til lange tekster. De kan også knytte sammen ord som er langt fra hverandre - f.eks. i en tekst med flere avsnitt - noe LSTM-er ikke klarer.

Hvorfor er GAN-er og diffusjonsmodeller viktige i generativ AI?

GAN-er og diffusjonsmodeller er spesielt gode til å lage bilder, lyd og video. GAN-er bruker to nettverk som konkurrerer - en lager, en sjekker. Diffusjonsmodeller starter med støy og fjerner den gradvis for å lage et bilde. Begge gir mye mer realistiske resultater enn tidligere metoder - og de er grunnen til at vi nå kan lage bilder fra tekst.

Hva er største utfordringen med transformers i dag?

De bruker for mye energi og minne. Hvis du dobler lengden på teksten, så bruker du fire ganger så mye minne. De kan ikke regne presist, de lager falske fakta (hallusinasjoner), og de er svært vanskelig å forstå - du vet ikke hvorfor de svarer som de gjør. Det er ikke en feil - det er en konsekvens av hvordan de er bygget.

Hva kommer etter transformers?

Forskere jobber med nye arkitekturer som Mamba, som bruker "state-space modeling" for å unngå kvadratisk minnebruk. Andre forsøker å kombinere transformers med energibaserte modeller eller fysikkbaserte modeller for å bygge sanne verdensmodeller. Mange tror at neste store gjennombrudd ikke vil være større modeller - men mer effektive, mer forståelige, og mer tilknyttet virkeligheten.

Post Comments (9)

Det her er klassisk AI-hype med en sideord av matematisk nostalgia. Markov-kjeder? Ja, fint. Men nå har vi transformers som kan generere hele kapitler i én sekund - og du vil fortsatt snakke om sannsynlighetsmatriser? 🤦♀️ Det er som å feire en pedaler på en Tesla. Vi er ikke lenger i 1913. Vi er i en verden der en modell kan skrive en novelle i Stieg Larssons stil og så lage et bilde av den samme karakteren som en cyborg katt. Det er ikke statistikk. Det er *magi* med GPU-er.

Vi forveksler kompleksitet med intelligens.

En maskin kan etterligne, ikke forstå.

Det er ikke teknologi som er problemet.

Det er menneskets ønske om å se sjelen i maskinen.

Det er imponerende å se hvordan denne teknologien har utviklet seg over tid, fra en ren matematisk hypotese til et verktøy som påvirker kultur, kunst og kommunikasjon på en fundamental nivå. Det er viktig å huske at hver av disse stegene - Markov-kjeder, LSTM, transformers - bygget på tidligere arbeid, og at fremgangen ikke skjedde i et vakuum. Det er en historie om samarbeid, tålmodighet og vitenskapelig respekt for det ukjente.

hei! jeg skjønte nesten ingenting av det du skrev men jeg elsker at du tok tid til å skrive det 😊

men jeg tenkte på at når ai skriver dikt så er det jo ikke *sannt* dikt fordi ingen føler det... men det ser ut som det gjør? det er så rart

kan vi stole på noe mer nå? 😅

Det er viktig å presisere at transformers ikke er "bedre" enn LSTM-er i alle henseender - de er bare mer effektive for veldig lange sekvenser og parallelle beregninger. LSTM-er har fortsatt fortrinn i ressursbegrensede miljøer og er mer transparente i sin læring. Det å kalle transformers en "revolusjon" er korrekt, men vi bør unngå å diskreditere tidligere arbeid. De er ikke erstattere - de er utvikling.

LOL sånn her skjønner jeg ikke hvorfor folk tror ai er smart. den skriver bare etter hva den har lest. jeg har sett den skrive en tekst om kaffe og så si "kaffe er en type fugl" 🤡

men det er jo mega kult at den kan skrive det så bra at folk tror den vet hva den snakker om 😂

gjør det bare ikke til jobb din, det er ikke en karriere det er en fiksjon med fakta

det er så kult at ai kan lage bilder av katter som spiser pizza på månen men jeg har prøvd å få den til å lage to like katter og de blir alltid litt ulike 😅

det er som om den ikke husker at katter har fire bein... men den husker at de ofte har det i bilder? det er så underlig

men likevel, jeg bruker det til å lage gaver til vennene mine og de liker det veldig 😊

Jeg vil bare si takk til deg som skrev dette. Det er ikke bare teknikk - det er en reise. Og vi er alle med på den, uansett om vi skriver kode eller bare bruker det til å lage en bilde til barnet sitt.

Det er ikke om å bli bedre enn mennesker. Det er om å bli bedre sammen.

Hold på det.

Det som fascinerer meg er ikke hvordan modellene fungerer - men hvordan vi reagerer på dem. Vi gir dem navn. Vi tilskriver intensjoner. Vi blir sinte når de lager feil. Vi elsker dem når de skriver et dikt som rører oss. Er det ikke mer om oss selv enn om dem? 🤔

Vi ser et speil - og tror det er et ansikt.