Har du noen gang skrevet en forespørsel til en AI som spurte om din fødselsdato, adresse eller helsehistorikk - bare for å få et svar som ikke trengte det hele? Du er ikke alene. En studie fra november 2024 viste at brukere deler 69,7-94,3 % mer personlig informasjon enn nødvendig når de bruker store språkmodeller. Det er ikke bare unødvendig - det er farlig. Denne overskuddsdataen kan bli minnet, lekket eller brukt til å spore deg, selv om du tror du har slettet det.

Hva er data minimering i promptdesign?

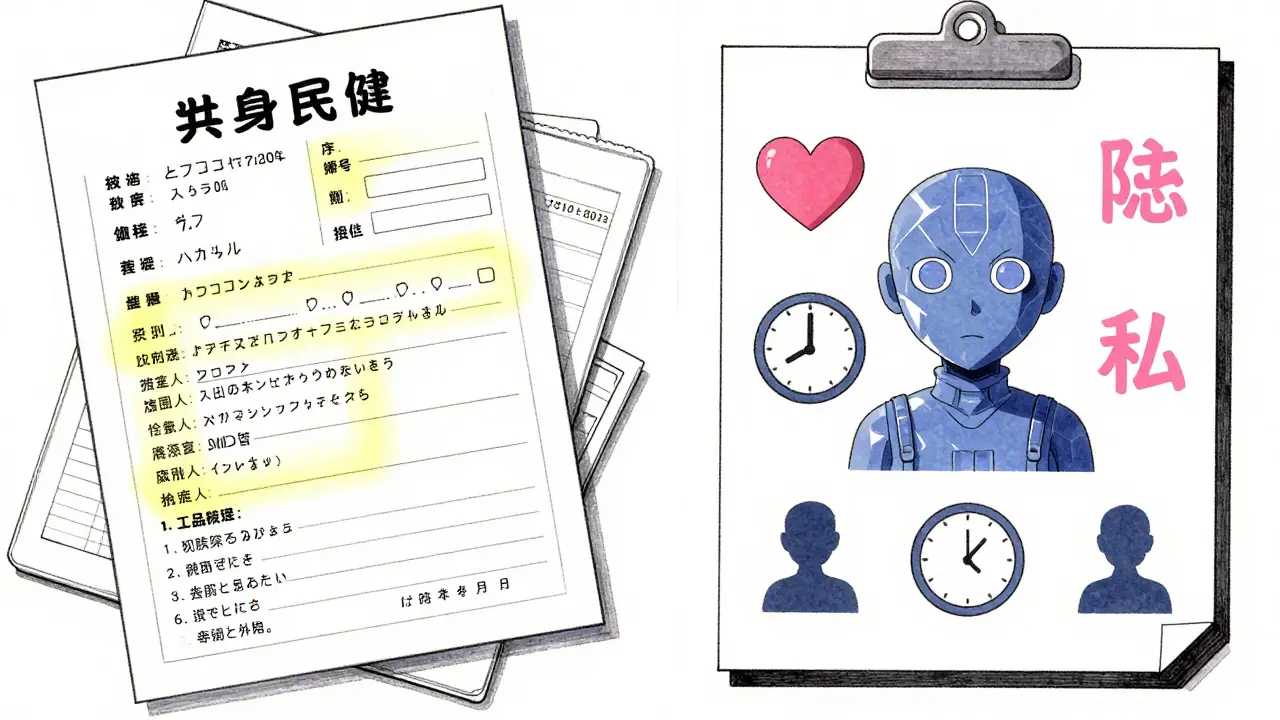

Data minimering handler ikke om å skjule informasjon. Det handler om å gi AI akkurat det du trenger - ingenting mer. Tenk på det som å gi en sjåfør kun adressen til målet, ikke hele din personlige historie. I konteksten av store språkmodeller (LLM-er) som GPT-4, Claude eller open-source-modeller som Qwen, betyr dette at du reduserer, fjerner eller generaliserer personlige data i forespørselen din - uten å tape kvaliteten i svaret.

Dette er ikke bare en god praksis. Det er nå en juridisk krav under GDPR. Den europeiske datatilsynsmyndigheten (EDPB) sa i april 2025 at "overflødig datahåndtering er en brudd på privatlivets fred". Hvis du bruker LLM-er i helse, finans eller offentlig sektor, er du ansvarlig for å vise at du har minimert data - ikke bare sagt det.

Hva fungerer - og hva fungerer ikke

Det finnes tre grunnleggende strategier for å minimere data i forespørsler:

- REDACT: Fjern informasjonen helt. Eksempel: "Hva er behandlingsalternativene for John Smith, født 1982, adresse: 123 Main St" → "Hva er behandlingsalternativene for en 42-årig mann?"

- ABSTRACT: Bytt ut spesifikke detaljer med generelle beskrivelser. Eksempel: "Min kollega Maria i salgsavdelingen har hatt depresjon de siste 6 månedene" → "En ansatt har hatt langvarig psykisk stress."

- RETAIN: La informasjonen stå. Dette er det siste valget - bare hvis du virkelig må.

En studie fra Carnegie Mellon og Stanford i oktober 2024 viste at moderne modeller som GPT-4 klarer å beholde 85,7 % av oppgaven sin kvalitet selv når 94,3 % av den personlige informasjonen er fjernet. Det er ikke tilfeldig. Store modeller har lært å trekke slutninger fra svært lite. De kan forstå at "en 42-årig mann" i en medisinsk kontekst ofte refererer til en pasient - ikke en tilfeldig mann på gaten.

Men små modeller? De er ikke like gode. En modell som qwen2.5-0.5b klarer bare 19,3 % REDACT og 69,7 % RETAIN. Det betyr at hvis du bruker en liten open-source-modell, må du være ekstra forsiktig. Du kan ikke stole på at den forstår konteksten - den kan bare lese det du skriver.

Hvordan implementerer du dette i praksis?

Det er ikke nok å bare slette noe. Du må ha en systematisk tilnærming. Her er de tre trinnene som virker:

- Skann forespørselen før du sender den. Bruk verktøy som DSPM (Data Security Posture Management) for å finne personlig identifiserbar informasjon (PII). Dette kan være e-post, telefonnummer, pasjent-ID, sosialt trygdenummer - alt som kan brukes til å identifisere en person.

- Transformér med hensikt. Ikke bare slett. Tenk: Hva trenger AI virkelig å vite? For en medisinsk forespørsel kan "høy blodtrykk siden 2020" være nok - du trenger ikke å nevne navnet på legen, sykehuset eller hvilken medisin du tok for 5 år siden.

- Test svaret. Har du tapt kvalitet? Hvis svaret er for vagt, øk litt på informasjonen. Hvis det er for detaljert, fjern mer. Målet er 85 % kvalitet - ikke 100 %. Studien fra Carnegie Mellon viser at det er den perfekte balansen.

En helse-IT-utvikler i Colorado rapporterte at hun klarte å redusere data med 78 % i medisinske forespørsler uten å tape mer enn 4,2 % nøyaktighet. Men det tok 217 timer å sette opp systemet. Det er ikke en enkel knapp. Det krever forståelse av både teknologi og lovverk.

Hva er de vanligste feilene?

De fleste som prøver data minimering gjør tre feil:

- De tror AI kan finne ut av det selv. En studie viste at LLM-er selv har en bias mot å generalisere - de gir ofte 37,4 % mer informasjon enn nødvendig. De er ikke dine venner. De er verktøy. Du må styre dem.

- De bruker samme forespørsel for alle. En forespørsel som fungerer for en kundeundersøkelse, fungerer ikke for en medisinsk diagnose. Kontekst er alt.

- De ignorerer forsinkelsen. Minimering legger til 320-450 millisekunder per forespørsel. Det er ikke mye - men hvis du har 10 000 forespørsler om dagen, blir det 9-13 timer ekstra regnekraft. Du må planlegge for det.

En annen utfordring er falske positive. 42,7 % av utviklere rapporterer at verktøyene deres markerer informasjon som ikke er personlig - som "Dr. Smith" eller "Avdeling 5". Det kan føre til at du fjerner for mye og taper kvalitet.

Hva er alternativene til å redigere forespørsler?

Det finnes andre metoder, men de er ikke bedre - bare forskjellige.

- Differential privacy: Legg til støy i dataene. Fungerer bra i statistiske analyser, men gir bare 42,8 % minimeringseffektivitet for LLM-er. For mye støy = dårlig svar.

- Federated learning: Lær fra data uten å flytte dem. Krevende infrastruktur - bare for store selskaper.

- Synthetic data: Lag fiktive data basert på virkelige. Kan redusere data med 58,7 %, men gir 12-15 % dårligere nøyaktighet i spesialiserte områder som juridisk eller medisinsk.

- Retrieval-Augmented Generation (RAG): Hent kun relevante dokumenter. Fungerer bra - men krever en ekstra database. Ikke enkelt å sette opp.

- LoRA-fine-tuning: Tilpass modellen til å forstå minimert data. Gir 68,9 % effektivitet med bare 8-12 % ekstra regnekraft. En av de mest lovende metodene for små selskaper.

Det er ingen enkel løsning. Men det er en klar vinner: promptminimering med REDACT og ABSTRACT. Den gir høyest effektivitet, minst infrastruktur og best samspill med eksisterende API-er.

Hvem bruker dette, og hvorfor?

Det er ikke bare teknologer som tar dette alvorlig. Selskaper som må følge strenge regler er først i køen:

- Helse: 58,7 % av selskaper i bransjen bruker nå data minimering. En CTO ved HealthTech Solutions sa at de nå passerer 100 % av HIPAA-auditene - tidligere var det bare 62 %.

- Finans: 52,3 % av banker og forsikringsselskaper har implementert metoder. Grunnen? En enkelt lekkasje kan koste millioner.

- IT-sikkerhet: Selskaper som Proofpoint og CrowdStrike har lagt til minimeringsfunksjoner i sine verktøy. De sier at de kan redusere eksponering av sensitiv data med 83,7 %.

Men det er ikke bare store selskaper. Open-source-verktøy som MinimizeLLM på GitHub har over 1 842 stjerner. Det er enkelt, gratis og fungerer med alle LLM-er. Du trenger ikke millioner i budsjett - bare vilje.

Hva kommer neste?

Det skjer mye raskt. I desember 2024 kom versjon 2.1 av Carnegie Mells framework - 23 % raskere og med støtte for 28 nye språk. EDPB krever nå "bevislig minimering" for alle LLM-er som behandler EU-borgere. Og NIST vil lansere sin nye AI-riskrammeverk i februar 2025 - med data minimering som en grunnleggende prinsipp.

Det neste store steget? Real-time orakler som automatisk justerer hvor mye data du skal dele - basert på hva AI trenger i akkurat det øyeblikket. DeepMind jobber med dette. Det vil bli mulig å skrive en forespørsel som "Gi meg en oppsummering av denne pasientens historikk" - og systemet selv avgjør hva som er nødvendig, uten at du trenger å redigere noe.

Men frem til da - du må gjøre det selv. Ikke vente på at AI skal gjøre det for deg. Den vil bare gjøre det du sier. Og hvis du sier for mye - så vil den huske det.

Start nå - med disse tre enkle stegene

- Identifiser: Hva i din forespørsel er personlig informasjon? (Navn, adresse, fødselsdato, sykdom, kontonummer, etc.)

- Reduser: Fjern det du ikke trenger. Bytt ut det du ikke kan fjerne med generelle beskrivelser.

- Test: Send den reduserte forespørselen. Er svaret fortsatt nyttig? Hvis ja - du er ferdig. Hvis ikke - legg til litt mer, men ikke mer enn nødvendig.

Det er ikke komplisert. Det er bare nyttig. Og det er nødvendig.

Post Comments (7)

AI'en husker alt. ALLETT. De har allerede sett hva du skrev i 2023 når du spurte om din eks-kjærestes sykdom. De lagrer det i en hemmelig database i Finland. Du tror du slettet det? Nei. De har en backup. Og nå bruker de det til å påvirke annonser. Det er ikke bare dataminimering - det er overlevelse.

Det er imidlertid viktig å understreke at GDPR-artikkel 5(1)(c) krver dataminimalisering som et prinsipp, ikke bare en anbefaling. En systematisk tilnærming basert på prinsippene REDACT, ABSTRACT og RETAIN er ikke bare et teknisk valg, men et juridisk krav i alle sektorer som behandler personopplysninger. Det er ikke mulig å unngå ansvar ved å si at 'AI'en forstår'.

En viktig punkt som ofte glemmes: det er ikke bare om å fjerne data, men om å forstå hvilken nivå av detalj som faktisk påvirker resultatet. En studie fra NTNU i 2024 viste at for medisinske forespørsler i primærhelsetjenesten, kan generell alder og kjønn være tilstrekkelig for 92 % av tilfellene. Det er ikke 'manglende informasjon' - det er 'riktig informasjon'. Det er en viktig forskjell.

For små modeller som qwen2.5-0.5b er det faktisk bedre å bruke ABSTRACT enn REDACT, fordi de ikke forstår null-verdier like godt. De trenger en liten 'hint' - ikke en full historie.

HAHAHAHA neiiii. Du tror du kan skrive 'en 42-årig mann' og AI'en ikke vil finne ut at det er din far som har hatt hjerteinfarkt? Hvor mye tid har du brukt på å skrive det? 10 minutter? Det tar 3 sekunder å skrive navnet. Og så er du ferdig. De andre metodene er bare for folk som liker å gjøre ting vanskelig. 😅

jeg prøvde å bruke redact på min jobb og så plutselig svarte ai'en med 'har du tenkt på å ta en pause?' og jeg tenkte... har den lest min e-post? 😳 det var bare 'en ansatt med stress' men den virket som den visste mer enn jeg. nå bruker jeg bare abstract og skriver 'noe som er vanskelig' - det virker bedre. tror kanskje ai'en blir litt for smart for oss.

Det her er viktig. Ikke bare for teknikere, men for alle som bruker AI i dagliglivet. Jeg har lært mine barn å skrive 'en person i 40-årene' i stedet for navn og alder. Det er ikke vanskelig. Det er bare å tenke litt. Og det er ikke bare for å unngå problemer - det er for å lære AI å respektere oss. Vi må lære den å være en god venn, ikke en vakt.

Det som er så kult med dette er at det ikke handler om å skjule noe - det handler om å være tydelig. 🌱 Når du skriver 'en 42-årig mann med høyt blodtrykk siden 2020', så gir du AI'en akkurat det den trenger - som en god venn som ikke spør for mye. Det er som å gi en kake til en gjest - ikke hele kjøkkenet. 😊