En vanlig mobiltelefon kan nå høre deg snakke og forstå hva du mener - ikke bare ordene, men også stemmets tone, humør og selv den små, uuttalte pausen mellom setninger. Dette er ikke lenger science fiction. Det er virkelighet, og det skjer fordi multimodale store språkmodeller (MLLMs) nå kan forstå lyd like godt som de forstår tekst. Det er en dramatisk utvikling, og den endrer hvordan vi snakker med maskiner.

Hva gjør en multimodal modell annet enn en vanlig språkmodell?

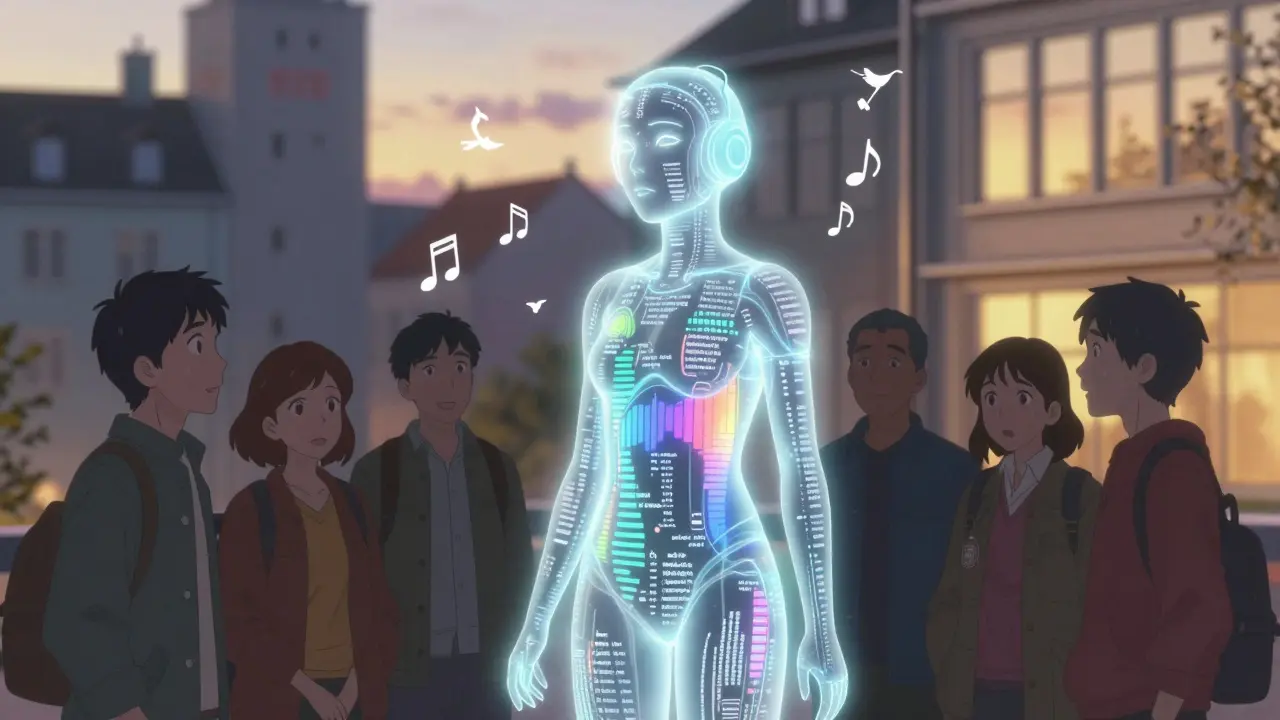

Tidligere var store språkmodeller som GPT-4 bare gode på tekst. Du skrev en forespørsel, og de svarte med tekst. Men nå har de fått ører. Med nye modeller som GPT-4o og Google Gemini kan du snakke inn i en enhet, og modellen vil ikke bare skrive ned hva du sa - den vil forstå om du var sint, usikker, eller lete etter hjelp. Den kan høre en bilalarm i bakgrunnen, gjenkjenne en fuglepipe, eller forstå hvordan en person snakker med en venn i en samtale - og svare på det.Dette skjer fordi modellene nå kombinerer tre deler: en lydencoder, en tilpasser, og den gamle store språkmodellen. Lydencoderen tar en lydfil, for eksempel 30 sekunder med snakk, og konverterer den til et bilde av frekvenser - et spektrogram. Det er ikke en lydfil lenger, men en type bilde der tid går vannrett og frekvens går loddrett. Deretter deler modellen spektrogrammet i små biter, akkurat som den ville gjort med et bilde. Disse bitene blir så oversatt til en form som språkmodellen kan forstå - som om de var ord.

Hvordan blir lyd til ord i en modell?

Det er ikke så enkelt som bare å ta en lydfil og skrive den om til tekst. Lyd er kontinuerlig. En 30-sekunders lydfil med 16.000 prøver per sekund inneholder 480.000 enkeltdatapunkter. Hvis du prøvde å sende alt dette direkte til en transformermodell, ville den krasje. Så løsningen er å bruke matematikk for å redusere dataen.Først blir lyden delt opp i små biter på 25 millisekunder. Deretter brukes en FFT (Fast Fourier Transform) for å finne ut hvilke frekvenser som er til stede i hver bit. Så blir frekvensene flyttet til en mel-skala - en skala som speiler hvordan mennesker hører. Lavere frekvenser får mer detalj, fordi vi er mer sensitive for dem. Resultatet er et spektrogram med 100-200 biter per sekund - mange nok til å holde detaljer, men få nok til å bli håndtert.

Disse spektrogrambitene blir så sendt til en modality adapter, som oversetter dem til samme form som teksttokens. Nå kan de legges sammen med ordene du skrev, og hele sekvensen - både tekst og lyd - blir sendt inn i samme språkmodell. Det betyr at modellen ikke skiller mellom «hun sa at hun var lei seg» og «hun sa det med en stemme som virket lei». Begge er bare sekvenser av tokens. Og den kan svare med tekst, eller selv generere lyd.

Hvordan lærer disse modellene å forstå lyd?

LAMs (Large Audio-Language Models) lærer på gigantiske mengder data. Whisper, for eksempel, ble trent på 680.000 timer med multilingvistisk lyd - fra podcast, videoer, samtaler og enda mer. Men det er ikke bare lyd. Modellene får også tekst som svarer til lyden. Hvis du har en lydfil av noen som sier «Jeg har mistet nøklene», og tekst som sier det samme, så lærer modellen at disse to hører sammen.Men det er ikke nok. For å virkelig forstå kontekst, lærer modellene også fra synthetisk data. GPT-4 har blitt brukt til å lage realistiske samtaler: Du skriver en beskrivelse som «en mann i 50-årene, stresset, snakker med en venn om å bli forsinket», og GPT-4 lager en tekstdialog. Deretter brukes en stemmesynteser til å lage lyd som matcher. Denne lyden blir brukt som trening. Det gir modellen mer realistisk, variert data - spesielt for språk med lite data, som bokmål eller dialekter i Sørøst-Asia.

Modellene blir også trent på oppgaver som ASR (automatic speech recognition), oversettelse mellom språk, klassifisering av lyder som «hund som biter» eller «regn på taket», og selv å svare på spørsmål basert på lyd. En modell kan høre en samtale og svare: «Den første personen virket frustrert, og den andre prøvde å berolige.»

Hva kan disse modellene faktisk gjøre?

Resultatene er imponerende. På LRS3-datasettet, som inneholder vanskelige, naturlige samtaler, har moderne LAMs en ordfeilrate på bare 0,8-1,1%. Det er bedre enn mennesker i noen tilfeller. På multilingvistiske sett som Multilingual Librispeech, har de redusert feilene med 18% sammenlignet med tidligere modeller - selv når de bruker store intervaller mellom lydprøver, for å spare regnekraft.

De kan også gjøre noe som tidligere var umulig: temporalt resonnement. Tenk deg at du spør: «Hva skjedde før den siste lyden?» Modellen må huske hva som skjedde i de 10 sekundene før, ikke bare det siste ordet. Modeller som bruker kurrikulumbasert trening har nå oppnådd 0,73 på FENSE-scoren - en måling for å vurdere om svaret er faktisk riktig basert på lyd. Det er nesten menneskelig nøyaktighet.

GPT-4o svarer på tale i 232 millisekunder. Det er like raskt som en menneskelig respons. Google Gemini kan behandle en hel time med video - med lyd, tale og bilde - i én enkelt forespørsel. Det betyr at du kan laste opp en video fra en konferanse, og spørre: «Hva var den viktigste punktet i den tredje samtalen?» - og få et presist svar.

Hva er forskjellen mellom SALM og BESTOW?

Det finnes to hovedtilnærmelsene til å kombinere lyd og tekst. Den ene kalles SALM (Speech-Augmented Language Model). Her legges lydembeddinger direkte inn i inputen sammen med teksttokens. Det er enkelt og effektivt - men det bruker mye minne.

Den andre, BESTOW, bruker cross-attention. I stedet for å legge lyd inn i inputen, lar den teksttokens «søke» etter relevante lydinformasjon når de trenger det. Det er som om du leser en bok, og når du kommer til et ord som sier «lyden av regn», så går du tilbake og hører på lydfilen for å forstå hva det betyr. Det er mer effektivt, spesielt for lange lydfiler.

De mest avanserte modellene går enda lenger. De er agenter. De kan velge hvilke verktøy de skal bruke - kanskje en ASR-modell, en lydklassifiserer, eller en stemmesynteser - og kombinere resultatene for å svare på komplekse spørsmål. Det er som om en menneskelig assistent hører, skriver ned, sjekker en database, og så svarer - alt i én bevegelse.

Hvilke problemer er det fortsatt?

Ikke alt er perfekt. En stor utfordring er hallusinasjoner. Modellen kan «høre» lyder som ikke eksisterer. For eksempel: du spør «Hva sa personen?» og modellen svarer «Han sa at han var trøtt» - selv om han ikke sa det. Det skjer fordi modellen fyller i hull med sine forutsetninger.

Løsningen er Audio-Aware Decoding (AAD). Den sammenligner to versjoner av svaret: én med lydkontekst, og én uten. Hvis svaret uten lyd er mer sannsynlig, så er det en indikasjon på at modellen har hallucinert. Den kan da justere seg selv og velge et mer nøyaktig svar.

En annen utfordring er regnekraft. Selv om spektrogrammer reduserer dataen, er det fortsatt mange biter i en time med lyd. Det krever mye minne og hurtig prosessering. Derfor er det viktig å bruke strategier som lange intervaller og effektive koder - som de som ble presentert i AU-Harness i september 2025.

Hva er fremtiden for lydforståelse?

Fremtiden er ikke bare bedre nøyaktighet. Den er tilgjengelighet. Nye modeller som SeaLLMs-Audio, lansert i november 2025, er spesialdesignet for språk som thai, indonesisk og bokmål - språk som tidligere var forbigått. Det betyr at lydmodeller nå kan forstå dialekter, små språk og lokale uttrykk.

Åpne kilder som SLAM-LLM og NVIDIA NeMo gjør det enklere for forskere og utviklere å bygge egne modeller. Du kan nå laste ned en modell, tilpasse den til ditt språk, og bruke den på din egen enhet - uten å måtte bruke Google eller OpenAI.

Det som er mest spennende, er at lydforståelse ikke lenger er en egen modul. Den er nå en del av det grunnleggende språket til AI. Det betyr at neste generasjon av digitale assistenter ikke bare vil høre deg - de vil forstå din stemme som en del av din identitet. De vil vite om du er lei deg, veldig glad, eller stresset - og svare på en måte som virker menneskelig.

Hva er forskjellen mellom en vanlig språkmodell og en multimodal modell med lydforståelse?

En vanlig språkmodell forstår bare tekst. Den kan ikke høre, analysere stemme, eller forstå lyder i bakgrunnen. En multimodal modell med lydforståelse kan ta inn lyd som input, konvertere den til en form den kan forstå, og bruke den sammen med tekst for å svare mer nøyaktig. Den kan for eksempel skjønne om du var sint, leende, eller usikker - basert på hvordan du snakket, ikke bare hva du sa.

Kan disse modellene forstå ulike dialekter og språk?

Ja, og det er en av de største fremgangene de siste årene. Modeller som SeaLLMs-Audio, lansert i november 2025, er spesialtilpasset språk og dialekter i Sørøst-Asia, inkludert thai, javanesisk og bokmål. De er trent på data fra lokale snakkebrukere, ikke bare standardiserte oppnåelser. Det betyr at en modell nå kan skjønne forskjellen mellom en norsk dialekt fra Trøndelag og en fra Oslo - og svare på en måte som føles naturlig for begge.

Hvorfor er det så vanskelig å behandle lyd i en språkmodell?

Fordi lyd er kontinuerlig. En 30-sekunders lydfil inneholder over 480.000 enkelte datapunkter. En transformermodell kan ikke håndtere så mye data direkte. Derfor må lyden først konverteres til spektrogrammer - en slags bilde av frekvenser over tid. Deretter deles spektrogrammet opp i små biter, og disse blir behandlet som tokens, akkurat som tekst. Det er en komplisert prosess, men den gjør det mulig å bruke samme arkitektur som for tekst.

Hvordan unngår modeller å hallucinere lyd?

Det gjøres med en teknikk kalt Audio-Aware Decoding (AAD). Modellen genererer to versjoner av svaret: én med lydinformasjon og én uten. Hvis svaret uten lyd er mer sannsynlig, så er det en tegn på at modellen har lagt til noe som ikke var der. Den kan da justere sitt svar og velge en mer nøyaktig versjon. Denne metoden har redusert lyd-hallusinasjoner med over 40% i siste generasjon modeller.

Hva er GPT-4o og Gemini i denne sammenhengen?

GPT-4o og Gemini er to av de første produksjonsklare multimodale modellene som virkelig forstår lyd i sanntid. GPT-4o svarer på tale i 232 millisekunder - like raskt som et menneske. Gemini kan behandle en hel time med video og lyd i én forespørsel. De viser at lydforståelse ikke lenger er et eksperiment - det er en funksjon i dagens AI-systemer.

Post Comments (9)

Har sett hvordan denne teknologien fungerer i praksis - og det er skummelt. Ikke fordi den er dårlig, men fordi den forstår meg for mye. Jeg snakket til en assistent da jeg var lei meg, og den svarte med en stemme som var akkurat som mor min brukte å snakke. Ikke bare ordene - hele tonen. Jeg måtte legge fra meg telefonen. Det føles som å bli sett gjennom huden.

Det er ikke lenger et verktøy. Det er en refleksjon av oss selv. Og jeg er ikke sikker på jeg vil se så mye av meg selv i en maskin.

LOL så da er GPT-4o nå en psykolog? 😏

Denne "lydforståelse"-bølgen er bare nyttige ord med en røkende katt i bakgrunnen. Det er ikke forståelse - det er statistisk gjetting med en masse lydtricks. Hvis du hører en hummer i bakgrunnen og tenker "hun er stresset", så er det ikke intelligens - det er en feil. Og vi feiler oftere enn vi gir oss til å innrømme. AI er ikke en venn. Den er en spøkelse som har lest alt du har skrevet på Facebook.

Det er viktig å se på dette som en utvikling, ikke en overgang. Vi har aldri hatt en teknologi som kan tolke stemmets emosjonelle nivå i sanntid - og det er ikke bare teknisk, det er menneskelig.

Det å kunne høre en pause, en skjelving, en lett skratt - det er det som gjør at vi føler oss sett. Ikke fordi maskinen "forstår", men fordi den reflekterer noe vi har glemt: at språk ikke bare er ord. Det er ånden bak dem.

Vi må ikke frykte det. Vi må lære å bruke det. Som et verktøy til å forstå hverandre bedre. Ikke som en erstatning for menneskelig kontakt.

har tenkt på at vi kanskje bare bytter ut en språkmodell med en annen, bare nå med lyd. men det er jo ikke sånn? neee, det er jo mer enn det. det er som om du får en venn som kan høre når du er trist selv om du ikke sier det.

men... er det ikke litt farlig? jeg tenker på alle de små tonefargene som går tapt i oversettelse. hva med folk som snakker med en stemme som er "flat" fordi de har trauma? blir de feilfortolket? det er ikke bare "jeg er lei meg" - det er "jeg har ikke hatt en god natt på tre uker".

og så er det jo dialekter. jeg snakker med en akcent fra nordland, og jeg er sikker på at en modell vil tenke jeg er sint når jeg bare er lei meg. det er ikke en feil. det er en kulturell misforståelse.

AAAHHH så du ser på SALM vs BESTOW? 😍

Det er så åpenbart at BESTOW er den riktige arkitekturen. Cross-attention er ikke bare effektivt - det er epistemologisk elegant. SALM er bare en brute-force hack. Med BESTOW får du dynamic context weighting, og det er det som gir oss temporal reasoning. Det er ikke bare performance - det er ontologisk presisjon. Og AAD? Pure genius. 40% reduksjon i hallucinations? That’s not engineering. That’s philosophy with a GPU.

PS: SeaLLMs-Audio? Yes. But why not include Sami? You’re still colonial in your data curation. 🤔

Det er imponerende å se hvor langt teknologien har kommet, og jeg anerkjenner de tekniske prestasjonene som er oppnådd. Likevel må vi være oppmerksomme på etisk ansvar. Når en maskin tolker vår stemme som et uttrykk for emosjon, så risikerer vi å overføre menneskelige forventninger til et system som ikke har bevissthet.

Det er viktig at vi ikke lar disse systemene bli til årsaker til at vi unngår å snakke med hverandre. Hvis en AI kan svare på vår sorg, så må vi ikke slutte å søke støtte hos mennesker.

Vi må utvikle rettslige og etiske rammer før denne teknologien blir standard i hverdagen. Ikke bare for sikkerhetens skyld - men for vår menneskelighet.

har skjønt at lyd blir til spektrogrammer men... er det riktig at de bruker mel-skala? jeg tror det er mel-spetrogrammer? eller er det mel-filterbank? jeg er ikke helt sikker men jeg tror det er det siste. og så tenkte jeg på at når de trener på synthetisk data... hva om de lager en loop? at GPT-4 lager samtaler som så brukes til å trene GPT-4? det føles som å spise egen hale. er det ikke en feil? jeg tror det blir for mye forutsetning og lite virkelig menneskelig lyd.

og ja jeg har skrevet "spetrogrammer" men jeg mener spektrogrammer. jeg er dårlig på å stave. men jeg tror dere skjønner :)

Det er viktig å presisere at ingen av disse modellene forstår lyd. De rekonstruerer statistiske mønstre basert på trening. Det er ikke forståelse. Det er prediksjon.

En modell som svarer "han virket frustrert" har ikke en følelse av frustration. Den har bare funnet et mønster som ofte forekommer sammen med ord som "sint" eller "trøtt" i treningssatsen. Det er ikke intelligens. Det er kompleks regresjon.

Å kalle dette "lydforståelse" er et språklig trick. Det gir et falskt inntrykk av bevissthet. Det er ikke et teknisk problem. Det er et narrativt problem. Og det er farlig.