Generative AI-modeller som GPT, Llama og Claude ser ut til å tenke og skrive som mennesker. Men bak hver god respons ligger ikke bare algoritmer - det ligger en grundig, godt bygget data-pipeline. Uten riktig data, er ingen modell god. Og det er her deduplisering, filtrering og blanding av data blir kritisk. Du kan ha den mest avanserte modellen i verden, men hvis du trener den på duplisert, lavkvalitets eller urettferdig blandet data, vil den lære feil mønstre. Og da gir den dumme, farlige eller meningsløse svar - på skala.

Hvorfor data-pipelines er mer viktige enn modellarkitektur

Mange tror at større modeller = bedre resultater. Det er delvis sant. Men det er ikke nok. I 2024 viste CDInsights at modeller trent på data med streng deduplisering presterer 22% bedre i kvalitet enn modeller trent på rå, urensede data. Det er ikke en liten forskjell. Det er forskjellen mellom en modell som kan brukes i produksjon og en som bare forstyrer arbeidet ditt. Microsofts egen forskning viser at 25-35% av hele prosesserings-tiden i en data-pipeline går til deduplisering. Det er mer tid enn det som brukes til å trene selve modellen. Hvorfor? Fordi generative modeller er ekstremt følsomme. De vil gjerne lære seg feil ting - en duplisert tekst, et giftig svar, en feilaktig kodeeksempel - og så gjenta det millioner av ganger. Det er ikke en bug. Det er en funksjon av hvordan de lærer.Deduplisering: Fjern det du ikke trenger

Når du henter data fra internett - for eksempel fra Common Crawl - får du en haug med duplikater. En artikkel kan være kopiert 50 ganger på forskjellige nettsteder. En kodeblokk kan dukke opp i flere GitHub-repositorier. En Reddit-innlegg kan bli kopiert til flere forum. Hvis du ikke fjerner disse, trener modellen på samme informasjon igjen og igjen. Det gir ingen ny vinning - bare forbruk av regnekraft og tid. De beste pipeline-løsningene bruker MinHash og Locality-Sensitive Hashing (LSH) for å finne nesten-identiske tekstblokker. AIAccelerator Institute fant at disse metodene oppnår 98,7% nøyaktighet i å identifisere duplikater. Det betyr at for hvert 100 dokumenter, bare tre blir galt klassifisert. Det er to nivåer: dokumentnivå og avsnittsnivå. Dokumentnivå fjerner hele sider som er duplikater. Avsnittsnivå er mer avansert - det fjerner bare de delene som er duplisert, og lar resten stå. Dette er viktig for å bevare semantisk mangfold. Meta brukte avsnittsnivå deduplisering i Llama 3 og reduserte datasettet med 28% uten å tape presisjon i svar. En bruker på GitHub, "AI-Researcher99", bygget en egen LSH-pipeline som fjernet 99,1% av duplikatene fra Common Crawl-data. Resultatet? $28.000 i besparelser per modell-iterasjon. Det er ikke bare effektivitet - det er penger i lommen.Filtrering: Slett det som er farlig eller dårlig

Deduplisering fjerner det samme. Filtrering fjerner det dårlige. En god data-pipeline har flere filtreringstrinn:- Giftig innhold: Bruker klassifikatorer som Perspective API for å fjerne hate speech, trusler, diskriminering og seksuelt innhold.

- Kvalitetsscore: Måler perpleksitet - hvor uforutsigbar tekst er. Høy perpleksitet = usikker, kaotisk tekst. Lav perpleksitet = god, flytende tekst. Modeller lærer bedre fra det siste.

- Domene-relevans: Hvis du trener en modell for medisinsk QA, trenger du ikke 60% av dataene fra humor-sider eller kokebøker. Filtrer bort det som ikke hører hjemme.

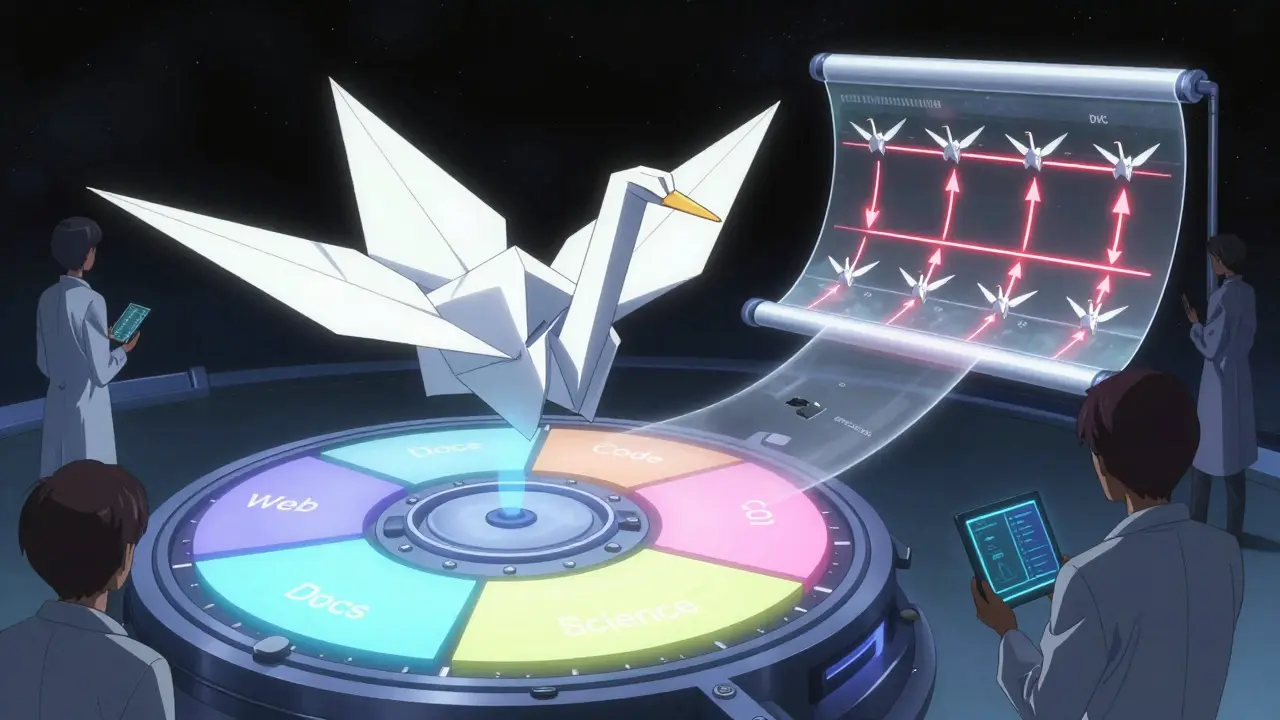

Blanding av data: Hva du legger inn, bestemmer hva modellen blir

Dette er det mest oversettede elementet. Du kan ha perfekt deduplisering og filtrering - men hvis du blander feil data, får du en feil modell. For en modell som skal skrive kode, bruker Anthropic (Claude 3) denne blandingen:- 60% generell web-innhold

- 20% teknisk dokumentasjon

- 15% kode (GitHub, Stack Overflow)

- 5% vitenskapelig litteratur

Data-versionering: Din sikkerhetsnet

AIAccelerator Institute fant at 78% av mislykkede modell-iterasjoner skyldes uovervåkede dataendringer. Du endrer en fil. Du tror ikke det har noe å si. Men modellen lærer noe annet. Og du skjønner ikke hvorfor. DVC (Data Version Control) løser dette. Det sporer hver endring i dataene - med nøyaktighet på 0,1%. Hvis du endrer blandingen fra 60/20/15/5 til 62/18/15/5, blir det registrert. Du kan gå tilbake til en tidligere versjon. Du kan dele den med kollegaene dine. Du kan dokumentere hvorfor du endret den. Dette er ikke bare teknisk. Det er et krav. EU’s AI Act (som trer i kraft februar 2026) krever detaljert dokumentasjon av alle trinn i data-pipeline. Du må kunne vise: Hvilke data? Hva ble fjernet? Hvorfor? Når?Open source vs. cloud-løsninger: Hva skal du velge?

Det finnes tre hovedveier:| Løsning | Deduplisering | Filtrering | Kostnad per GB | Setup-tid | Transparens |

|---|---|---|---|---|---|

| AWS SageMaker | 92% nøyaktighet | God, men usynlig | $0.15 | 2-3 uker | Lav |

| Kubeflow Pipelines | 95% nøyaktighet | Modular, tilpassbar | $0.04 | 3-4 uker | Høy |

| Meta DataComp | 95.7% nøyaktighet | Åpen algoritme | $0.00 (open source) | 4+ uker | Ekstremt høy |

| Microsoft Azure | 94% nøyaktighet | Intelligent balansering | $0.10 | 2 uker | Middels |

Hva kommer neste? Autonome pipeline

I 2025 begynner pipeline-ene å tenke selv. Microsofts nye Azure-funksjon justerer blandingen automatisk basert på hvordan modellen presterer. Hvis modellen blir dårligere på kode, øker den andelen kode-data. Hvis den blir for repetitiv, øker den mangfoldet. AWS har lagt til en "automatisk dedupliseringstilpassning" som forbedret effektiviteten med 28% i 127 kundeprosjekter. Google viser "selvhelende pipeline" - systemer som oppdager og retter opp dårlig data uten menneskelig inngripen. Det er ikke science fiction. Det er nå. Og det betyr at fremtidens dataingeniør ikke bare bygger pipeline - han overvåker dem. Han setter mål. Han ser på indikatorer. Og han lar AI gjøre det tunge arbeidet.

Hvordan begynne

Du trenger ikke å bygge alt fra bunnen. Her er en enkel start:- Start med en liten datasett - 10 GB, ikke 10 TB.

- Bruk Apache Airflow for å orchestre trinnene (deduplisering, filtrering, blanding).

- Legg til DVC for å versionere data.

- Test med en enkel modell - ikke GPT-4, men en liten Llama-variant.

- Mål: Hvor mye tid sparer du? Hvor mye penger? Hvor mye bedre er output?

Feil å unngå

- Ikke trene på rå data: Hvis du henter fra Common Crawl og går rett til trening - du vil bare skape kaos.

- Ikke ignorere blanding: 5% feil data kan ødelegge 20% av presisjonen.

- Ikke bruk samme data i trening og testing: Det gir falsk nøyaktighet.

- Ikke se bort fra dokumentasjon: Du vil ikke huske hvorfor du gjorde det for 3 måneder siden.

Det enkle svar

Generative AI er ikke bare om å ha en stor modell. Det er om å ha en ren, godt bygget data-pipeline. Deduplisering fjerner det du ikke trenger. Filtrering fjerner det som er farlig. Blanding sørger for at modellen lærer riktig ting. Versionering sørger for at du vet hva du har gjort. Og automatisk optimalisering gjør at det fortsetter å fungere. Det er ikke glamour. Det er ikke koding i 24 timer. Det er arbeid. Men det er arbeidet som skiller modeller som fungerer fra modeller som bare forstyrrer.Hvorfor er deduplisering så viktig i generative AI?

Deduplisering fjerner identiske eller nesten-identiske tekster fra datasettet. Hvis modellen ser samme tekst tusen ganger, lærer den ikke mer - den bare gjentar. Dette forbruker regnekraft og gir dårligere generalisering. Ved å fjerne duplikater, reduseres datasettet med 15-30% uten å tape informasjon - og modellen lærer mer effektivt.

Hva er forskjellen mellom deduplisering og filtrering?

Deduplisering fjerner duplikater - det samme innholdet flere ganger. Filtrering fjerner dårlig, farlig eller irrelevante data - som giftig språk, lavkvalitets tekst eller innhold som ikke hører hjemme i domenet. Det er to forskjellige trinn: én fjerner redundans, den andre fjerner skade.

Hva betyr "mixture design" i praksis?

Mixture design handler om å bestemme hvor mye av hver type data du bruker. For eksempel: 60% web, 20% teknisk dokumentasjon, 15% kode, 5% vitenskapelig litteratur. Hvis du legger inn for mye av én type - f.eks. 40% Reddit-innlegg - vil modellen bli for slang-orientert. Riktig blanding gir balansert, nøyaktig og fleksibel prestasjon.

Hvorfor er data-versionering kritisk?

78% av mislykkede AI-modeller skyldes uovervåkede endringer i data. Hvis du endrer datasettet og ikke husker hva du endret, kan du ikke reprodusere resultater. DVC eller lignende verktøy sporer hver endring med nøyaktighet på 0,1%, så du kan gå tilbake, sammenligne og forstå hvorfor en modell plutselig ble dårligere.

Er open source-pipeline bedre enn cloud-løsninger?

Det avhenger av hva du trenger. Cloud-løsninger som AWS SageMaker er enklere og raskere å sette opp, men du har lite kontroll over hva som skjer i bakgrunnen. Open source som Kubeflow eller Meta’s DataComp krever mer arbeid, men du forstår og kontrollerer hvert trinn - noe som er nødvendig for forskning, regulering og sikkerhet.

Hva er den største fellen i data-pipeline-arbeid?

Å tro at "data er ferdig". Data er ikke en enkelt fil du laster opp og glemmer. Det er en levende strøm. Du må overvåke drift, data-drift, og modell-prestasjon kontinuerlig. Det er ikke en enkelt prosess - det er en syklus.

Post Comments (10)

Det her er så sjell, men jeg tror vi glemmer at AI bare gjentar hva vi gir den. 😅 Hvis du trener på Reddit og 4chan, får du en modell som skriver som en 16-årig som tror han er en filosof. Har sett det skje. Ikke glem å filtrere bort de skittenste delene!

ikkje glemme dvc!! har prøvd å trene ein modell utan versionering og det blei ein kaos... 3 uker borte og ingen visste kva som var endra. jaja, vi må ha det. 😅

Det er så riktig med blandinga. Ein modell som berre har kode er som ein sjef som berre les tekniske manualer - han skjønner ikkje kva folk egentleg treng. 🤓

Det er viktig å understreke at deduplisering ikke bare reduserer kostnader, men forbedrer generaliseringen. Studier viser at modeller med streng deduplisering har lavere overtilpasning og bedre robusthet mot forskyvninger i data. Dette er ikke bare en teknisk detalj - det er en grunnleggende prinsipp i maskinlæring.

Det her er viktig arbeid, men ikkje gløym at dei fleste ikkje har ressursar til å byggje dette frå bunnen. Start med lite. Bruk open source. Prøv med 10 GB. Du vil sjå forskjellen. Ikke tenk på GPT-4 - tenk på kva du kan gjere i dag.

Det er jo bare en smal del av den store planen. Hvorfor tror du at alle disse open source-pipelineene ikke har noen hemmelige backdoors? Microsoft og Google har allerede bygget inn skjulte filter som fjerner alt som ikke passer deres narrative. DataComp? Det er bare en glitrende felle. Hvis du ser på hvem som finansierer Meta, så vet du at det ikke er frihet - det er kontroll med en annen farge. 🕵️♀️

95.7% nøyaktighet? Håpløst. Dei som skriv dette har aldri jobba med rå Common Crawl-data. Ein gang såg eg 12% av datasettet som var kopiert frå eit forum som var slettet i 2019 - og dei sa 'det er ikkje duplikat, det er 'variation'. Hva er det for ei logikk? Det er bare dårlig kvalitetskontroll. Det her er alle smuglerier med AI.

Autonome pipeline? Hør på deg selv. AI skal nå kontrollere dataene sine selv? Neste steg er at AI sletter sine egne feil og så lager seg nye myter om seg selv. Det er ikke teknologi - det er en ny religion. Vi er på vei mot en verden der AI bestemmer hva som er sant, og vi bare sitter og klapper.

Denne analysen er ufullstendig. Det nevnes ikke at deduplisering på avsnittsnivå kan føre til semantisk fragmentering, spesielt i kontekstuelle sammenhenger som juridisk eller medisinsk tekst. Videre, bruk av LSH forutsetter at hashfunksjonene er robuste mot syntaktiske variasjoner - noe som ikke alltid er tilfelle i ikke-engelsk tekst. Det er en viktig grense for generell anvendelse i norsk kontekst.

Alle disse kommentarene er viktige, men la oss ikke glemme det enkle: data-pipeline er som kjøkkenet i en restaurant. Du kan ha den beste kokken i verden, men hvis ingrediensene er forrådete, dupliserte eller blandet feil - så blir måltidet søppel. Ta det steg for steg. Ikke forsøk å bygge en Michelin-restaurant på en leilighet. Start med å rydde opp i skapet ditt først.