Tag: layer normalization

- January 27, 2026

- Comments 8

- Teknologi og kunstig intelligens

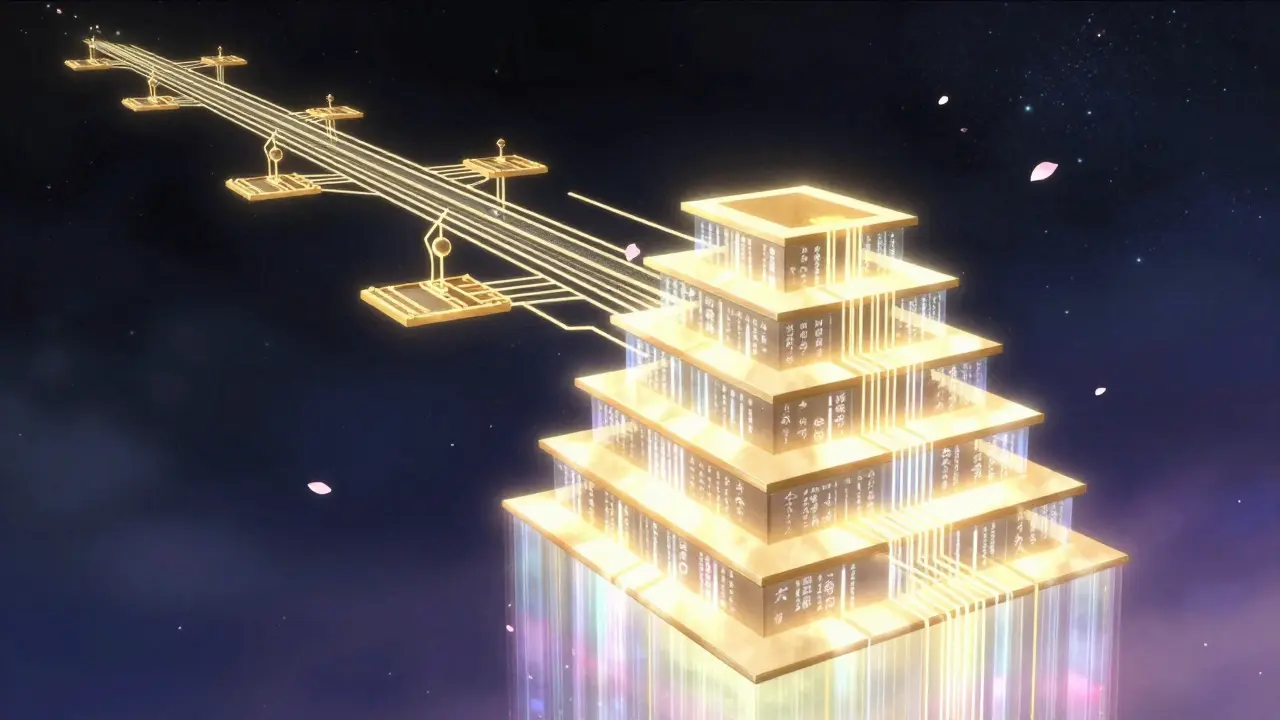

Layer Normalization og Residual Paths i Transformers: Stabilisering av LLM-utdanning

Layer Normalization og residual paths er nøkkelen til å trene stabile store språkmodeller. Denne artikkelen forklarer hvordan Pre-LN, RMSNorm og Peri-LN fungerer, hvilken du bør velge, og hvordan de har endret LLM-utvikling i 2026.

Read More

- August 1, 2025

- Comments 9

- Teknologi og kunstig intelligens

Residual Connections og Layer Normalization i Store Språkmodeller: Grunnleggende for stabil trening

Residual connections og layer normalization er nøkkelen til å trene dype store språkmodeller. Uten dem ville GPT, BERT og Llama ikke eksistert. Her forklarer vi hvordan de fungerer, hva som skiller Pre-LN fra Post-LN, og hvilke praktiske valg du må treffe.

Read More