Tag: LLM-komprimering

- February 8, 2026

- Comments 10

- Teknologi og kunstig intelligens

Komprimeringspipelines og verktøy for bedriftsbaserte LLM-team

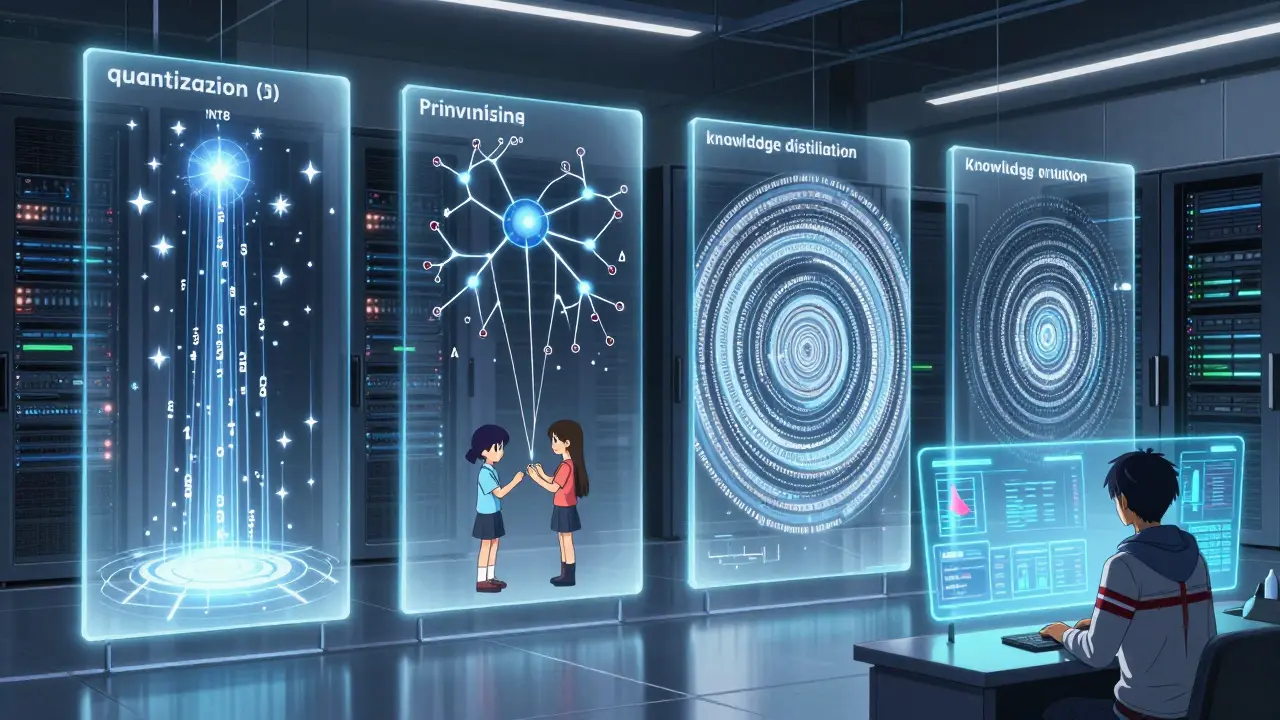

Komprimering av store språkmodeller reduserer kostnader og forbruk med opptil 80 %, samtidig som den gjør AI tilgjengelig for edge-enheter og RAG-systemer. Her forklarer vi de fire teknikkene, verktøyene i 2026 og hvordan du starter.

Read More