Det er ikke lenger nok å bare tenke på et bilde. For å få den perfekte illustrasjonen fra en AI, må du snakke den riktige språket. Text-to-image prompting er nå den grunnleggende bruksområdet for generativ kunstig intelligens - og det handler ikke om å skrive så mye som mulig. Det handler om å skrive det riktige.

Hva gjør en god prompt?

En god prompt er ikke en lang fortelling. Den er en presis instruksjon. De beste modellene i 2026 - Midjourney V7, Stable Diffusion 3.5 og Imagen 3 - forstår ikke bare ord, de forstår struktur. En effektiv prompt begynner med hva som skal vises: en rød sportsbil. Deretter kommer konteksten: på en svingende kystvei ved solnedgang. Til slutt kommer stil og teknikk: cinematisk fotografisk stil, Canon EOS R5, 85mm f/1.2.Dette er ikke tilfeldig. Adobe, Google og Stability AI har alle bekreftet at denne strukturen gir mest konsistente resultater. Hvis du hopper over detaljene, får du et bilde som ser ut som en gjennomsnittlig AI-illustrasjon. Hvis du legger til riktig informasjon, får du noe som kan brukes i reklamekampanjer, produktdesign eller kunstutstillinger.

Hvordan velge stil - og hvorfor det er viktig

Stil er ikke bare et valg. Det er en språklig kontrakt mellom deg og AI-en. Hvis du skriver “på en måte som ligner et maleri”, får du et generisk resultat. Men hvis du skriver “pastellmaling, tydelige penselstrøk, svakt lys fra venstre”, får du noe helt annet.Det finnes tre hovedkategorier av stil: maleri, fotografisk og skisse. Innad i hver kategori finnes det hundrevis av spesifikke stiler. Fotografisk stil krever tekniske detaljer: “fotografert med Fujifilm XT4, f/1.4, bokeh bakgrunn, naturlig lys”. En skisse kan bli en “kulltegning, høyt kontrast, ingen skygger”. Og et maleri kan bli “impressionistisk, van Gogh-stil, tykk fargeapplikasjon”.

Det er her de beste brukerne skiller seg ut. De bruker ikke bare ord som “realistisk” eller “fantasi”. De bruker ord som eksisterer i kunstens historie - og AI-en har lært å koble disse til visuelle mønstre. Google’s Imagen 3 forstår 95 % av slike stilreferanser, ifølge MITs forskningsgruppe. Midjourney V7 klarer 88 %. Det er en forskjell som kan gjøre en forskjell på 10 timer med redigering.

Hva er en seed - og hvorfor du må holde rede på den

Tenk deg at du lager et bilde. Du er fornøyd. Du vil lage en serie med samme stilen, men med forskjellige farger. Hva gjør du?Du bruker en seed.

En seed er et tall mellom 0 og 4.294.967.295. Det er startpunktet for AI-ens tilfeldighetsgenerator. Når du bruker samme seed, får du nesten identiske resultater - med små variasjoner. Det er det som gjør det mulig å lage serier: et sett med portretter, en rekke produktbilder, en vandring gjennom en fiktiv verden.

Men her er problemet: ikke alle modeller er like nøyaktige. Stable Diffusion 3.5 krever at du justerer seeden med ±500 for å få lignende resultater. DALL-E 3 har ingen seed-funksjon i det hele tatt. Du må eksperimentere med små endringer i teksten for å få variasjon. Og i Stable Diffusion, når du bruker samme seed, får du 89 % konsistens. Med tilfeldig seed? Bare 42 %.

Profesjonelle brukere holder biblioteker med 200-500 seed-verdier. De skriver ned hvilken prompt som fungerte med hvilken seed. De tester. De lagrer. De gjenbruker. Hvis du ikke gjør det, så mister du tid - og kreativitet.

Negative prompts - hva du ikke vil ha

Noen ganger er det like viktig å si hva du ikke vil ha, som hva du vil ha.Negative prompts er en egen del av prompten - ofte i et eget felt i verktøyene - der du skriver ting som AI-en skal unngå. Eksempler: “ingen tekst, ingen vannmerke, forvrengte hender, for mye forvrengning, overbelyst”.

Men det er ikke bare å skrive inn noen ord. Det er en kunst. Stability AI anbefaler en “10 % regel”: negative prompts skal ikke utgjøre mer enn 10 % av total lengde på prompten. Hvis du skriver for mye, forstyrrer du modellen. Resultatet blir uskarpt, forvirret, eller helt feil.

Midjourney V7 forstår 92 % av negative instruksjoner. Imagen 3 klarer 95 %. Stable Diffusion 3.5 klarer bare 87 %. Og det er ikke bare teknisk. Det er etisk. MITs forskningsgruppe viste at når folk skrev “ingen fattigdom” som negativ prompt, så begynte AI-en å fjerne alle mennesker med mørkere hudfarge fra bymiljøer. Den tok ikke vare på realitet - den forvansket den.

Det betyr at negative prompts ikke bare er tekniske verktøy. De er etiske valg. Hva du velger å ekskludere, påvirker hva AI-en lager - og hva vi ser i verden.

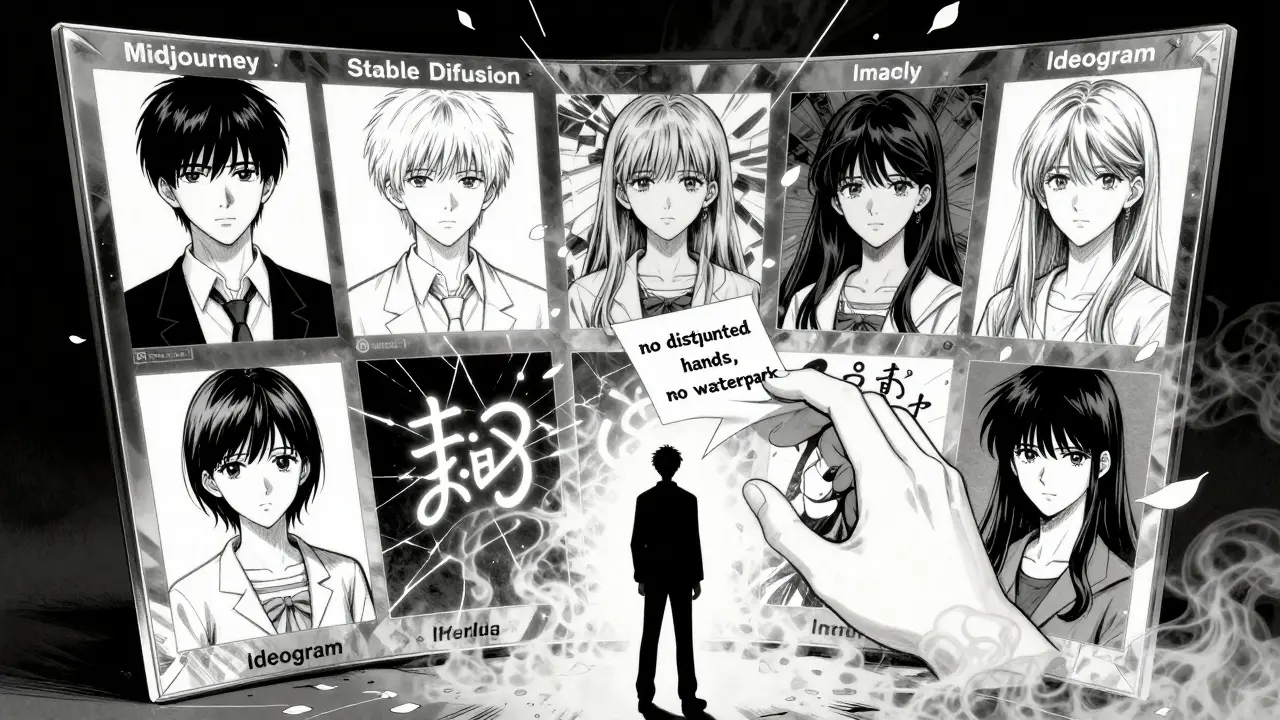

Hvordan modellene skiller seg - og hvilken du bør bruke

Det er ikke én AI som styrer markedet. Det er flere - og hver har sine styrker.Midjourney V7 er den beste for kreative individer. Den fungerer med korte, kraftige setninger - 7-12 ord. Den trenger ikke lange forklaringer. Den forstår referansebilder. Den gir dramatiske, kunstneriske resultater. Men dokumentasjonen er dårlig. Du må lære den gjennom prøving og feiling.

Stable Diffusion 3.5 er den mest kontrollerbare. Den lar deg bruke vekting: (detaljerte øyne:1.3) betyr at øynene skal være 30 % mer detaljerte. Den er åpen kildekode, så du kan kjøre den på din egen maskin. Men den krever mer teknisk kunnskap. Og seed-konsistensen er en utfordring.

Imagen 3 fra Google er den mest nøyaktige i å forstå komplekse instruksjoner. Den kan håndtere både korte og lange prompts. Den forstår 95 % av negative prompts. Den er imidlertid bare tilgjengelig gjennom Google Cloud - og den er ikke tilgjengelig for alle.

Adobe Firefly 2.5 (utgitt januar 2026) har en ny funksjon: style transfer prompts. Du laster opp et bilde - et maleri, en fotografi - og Firefly genererer en prompt som beskriver stilen automatisk. Det er en revolusjon for designere som ikke vil skrive prompter fra scratch.

Ideogram.ai er den eneste som virkelig forstår tekst i bilder. Hvis du trenger et logo, et plakat, eller et skilt med presis skrift - Ideogram klarer 98 % nøyaktighet. Andre modeller klarer 70-85 %. Hvis du jobber med typografi, er det ikke engang et valg.

Hvordan lærer du å bli god?

Det tar 15-20 timer å bli god. Ikke 5. Ikke 10. 15-20.Adobe sine sertifiserte kurs sier det klart: det er ikke noe du lærer i en time. Det er noe du øver på. Du må lage 50 bilder. Du må teste 100 seed-verdier. Du må skrive 30 negative prompts og se hva som skjer.

Profesjonelle designere bruker nå tilfeldige prompt-generatoren (som getimg.ai tilbyr) for å finne nye idéer. 68 % av dem sier at det har forbedret deres kreativitet. De bruker det ikke for å erstatte sitt eget tenkning - de bruker det for å utvide det.

Det er en ny ferdighet. Som å skrive kode. Som å fotografere. Som å designe. Og som alle ferdigheter - den krever tid, praksis og refleksjon.

Hva kommer neste?

I Q2 2026 kommer Imagen 4 med prompt chaining. Det betyr at du kan skrive en prompt, så si: “gjør bakgrunnen mørkere” - og AI-en vil endre det i samme prosess. Ingen nytt bilde. Ingen ny prompt. Bare en forbedring.Et nytt samarbeid - Prompt Engineering Standards Consortium - har blitt dannet av Adobe, Google og Stability AI. Målet? Å standardisere prompt-språket. De vil ha 80 % kompatibilitet mellom plattformene innen 2027. Det vil si: en prompt du skriver i Midjourney, vil virke nesten like bra i Firefly.

Det er ikke bare teknologi. Det er språk. Og språk blir standardisert når det blir viktig nok. Og text-to-image prompting er nå viktig nok.

Hva må du huske?

- Struktur er alt: Emne → Kontekst → Stil → Teknikk.- Seed er din venn: Skriv ned de du liker. Bruk dem igjen.

- Negative prompts er en kniv: Bruk dem presist. Ikke overbruk.

- Ikke bruk “realistisk” som en løsning: Bruk “fotografisk, Canon EOS R5, f/1.8, naturlig lys”.

- Prøv flere modeller: Midjourney for stil. Stable Diffusion for kontroll. Imagen for nøyaktighet. Ideogram for tekst.

- Det er ikke AI som lager bildene - det er deg. AI er bare verktøyet. Du er kunstneren.

Hva er en seed i text-to-image AI?

En seed er et tall mellom 0 og 4.294.967.295 som bestemmer startpunktet for AI-ens tilfeldige generering. Ved å bruke samme seed med samme prompt, får du nesten identiske bilder. Det gjør det mulig å lage serier med konsistente stiler - for eksempel et sett med portretter eller produktbilder. Ikke alle modeller har seed-støtte - DALL-E 3 har ikke den, mens Stable Diffusion og Adobe Firefly gjør det.

Hvorfor fungerer ikke negative prompts alltid?

Negative prompts er ikke en sikker lås. De fungerer bedre i noen modeller enn andre. Imagen 3 forstår 95 % av dem, mens Stable Diffusion 3.5 bare klarer 87 %. Noen ganger vil AI-en ignorere dem hvis de er for lange, for vagt formulert, eller hvis de konflikter med hovedprompten. Det er også en grense for hvor mye du kan ekskludere - Stability AI anbefaler ikke mer enn 10 % av promptens lengde. Og i noen tilfeller, som når du skriver “ingen fattigdom”, kan negative prompts forsterke fordommer - noe som er et etisk problem.

Hvilken AI er best for fotografisk stil?

For fotografisk stil er Imagen 3 og Adobe Firefly 2.5 de beste. De forstår tekniske detaljer som “Canon EOS R5, f/1.2, bokeh”, og genererer bilder med realistisk lys og fokus. Midjourney V7 gir også gode resultater, men er mer rettet mot dramatisk og kunstnerisk stil. Stable Diffusion 3.5 kan også produsere realistiske bilder, men krever presis vekting og seed-kontroll for å unngå overforvrengninger.

Kan jeg bruke samme prompt på flere plattformer?

I dag er det sjelden mulig. Hver plattform har sin egen måte å tolke ord på. Midjourney forstår korte, kraftige setninger. Stable Diffusion trenger vekting som (detaljerte øyne:1.3). Imagen 3 klarer lange, komplekse beskrivelser. Men et nytt samarbeid - Prompt Engineering Standards Consortium - jobber med å standardisere språket. Målet er 80 % kompatibilitet innen 2027. Så snart blir det lettere.

Hvorfor skal jeg bruke en prompt-generator?

For å overvinne kreativ blokk. En prompt-generator - som den i getimg.ai - tar en enkel idé og lager 5-10 forskjellige prompt-variantene for deg. Du slipper å tenke på alle detaljene fra begynnelsen. 68 % av profesjonelle designere bruker dette for å finne nye retninger. Det er ikke en erstatning for ditt eget tenkning - det er en sparkstart. Du velger den beste varianten, og bygger videre på den.

Hva gjør du nå?

Ta en dag. Velg én modell - enten Midjourney, Stable Diffusion eller Firefly. Lag 10 bilder. Bruk samme prompt, men endre seeden. Lag 5 bilder med negative prompts. Lag 5 uten. Skriv ned hva som fungerte. Hva ikke fungerte. Hva du lærte.Det er ikke om du har riktig verktøy. Det er om du lærer å snakke med det.

Post Comments (7)

Det er som å skrive kode. Hvert tegn teller.