Har du noen gang fått et svar fra en AI-assistent som virket rimelig, men likevel var helt feil? Det skjer ofte fordi systemet tok utgangspunkt i feil informasjon. Det er her reranking kommer inn. I RAG-systemer (Retrieval-Augmented Generation) henter systemet først inn flere dokumenter basert på en søkeforespørsel - ofte med vektorsearch. Men bare fordi et dokument inneholder ord som matcher spørsmålet, betyr ikke at det gir det beste svaret. Reranking løser dette ved å sortere de hentede dokumentene på nytt - ikke etter treff på nøkkelord, men etter semantisk relevans. Det er som å la en ekspert gå gjennom alle resultatene og si: «Denne her er den viktigste. Denne her er nærmest, men ikke helt riktig. Denne her kan du glemme.»

Hvorfor er reranking nødvendig i RAG?

Tenk deg at du spør en AI: «Hva er de siste reglene for skattefradrag for selvstendige i Norge i 2026?» Et vektorsearch-system kan hente inn ti dokumenter som inneholder ord som «skatt», «selvstendig», «fradrag» og «2026». Men én av dem er en gammel bloggpost fra 2023. En annen er en generell oversikt over skattesystemet uten konkrete tall. En tredje er en offisiell regeltekst fra Skatteetaten, men den er skjult i midten av listen. Uten reranking, vil LLM-en få denne blandede bunken og prøve å svare på grunnlag av alt det. Resultatet? En sammensatt, feilaktig eller ufullstendig oppsummering. Reranking løser dette ved å sette inn et annet skritt mellom henting og generering. Etter at de ti dokumentene er hentet, kjører de gjennom en modell som vurderer: «Hvor godt passer hvert dokument til denne spesifikke forespørselen?» Den modellen ser ikke bare på ord - den forstår mening, kontekst og intensjon. Den ser at «skattefradrag for selvstendige 2026» i en offisiell PDF er mye mer relevant enn «hvordan skatt fungerer i Norge» i en generell artikkel. Denne omorganiseringen sørger for at LLM-en får de fem beste dokumentene - ikke bare de fem som matcher ord for ord.Hva er de tre hovedtypene reranking?

Det finnes tre måter å gjøre reranking på - hver med sine egne styrker og svakheter.Punktvise reranking er den enkleste. Her spør du en LLM: «Hvor relevant er dette dokumentet for spørsmålet? Gi en score fra 1 til 10.» Modellen leser dokumentet, vurderer det mot forespørselen, og gir et tall. Deretter sorteres alle dokumentene etter score. Denne metoden er lett å forstå og implementere - men den kan bli ustabilt hvis LLM-en ikke er godt trenet på å gi nøyaktige tall. Noen ganger gir den 7, andre ganger 8 for det samme dokumentet.

Parvis reranking er mer nøyaktig, men mye tungere. Her sammenligner modellen to dokumenter om gangen: «Hvilket av disse to er mer relevant?» Den gjør dette for alle mulige par - hvis du har 10 dokumenter, må den gjøre 45 sammenligninger. Hver sammenligning krever en LLM-beregning. Det gir svært gode resultater, fordi modellen ikke bare vurderer hvert dokument isolert - den ser på forholdet mellom dem. Men det blir dyrere i tid og regnekraft. Det er som å la en dommer sammenligne alle par av løpere for å finne ut hvem som er den beste - i stedet for bare å gi hver løper en tid.

Listevise reranking tar alle dokumentene på en gang og lager en hel rekkefølge i én operasjon. Denne metoden er mer effektiv enn parvis, men mindre nøyaktig enn den. Den er god når du har mange dokumenter og trenger en rask, men god, sortering. Noen moderne modeller, som NVIDIA’s NeMo Retriever, bruker listevise metoder for å balansere hastighet og nøyaktighet.

Hvor mye bedre blir svarene?

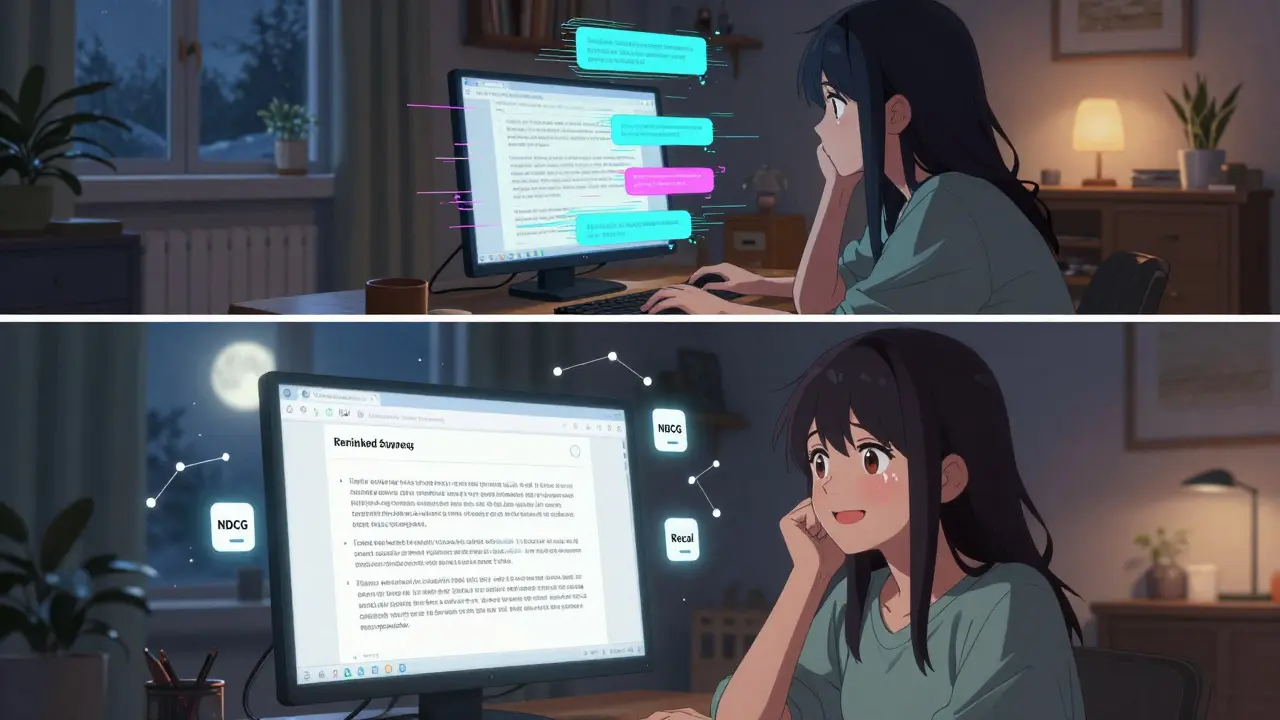

Det er ikke bare teori - det er målbare forbedringer. Ifølge analyser fra Haystack i februar 2024, så gir reranking:- En +6,80% økning i Recall@5 - altså at de riktige dokumentene dukker opp i de fem første resultatene mye oftere.

- En +5,59% økning i MRR (Mean Reciprocal Rank) - som betyr at det riktige dokumentet kommer tidligere i listen.

- En +5,90% økning i NDCG - en måling som vurderer både relevans og plassering i listen.

Det betyr at systemet ikke bare gir riktig svar oftere - det gir det riktige svaret fort. I et kundesupportsystem hos Fin AI, økte andelen «hjelpsomme svar» med 3 prosentpoeng, og andelen korrekte svar med 2 prosentpoeng. Samtidig sank antallet svar som citerer ugyldige eller generiske kilder med 27%, mens svar basert på offisielle dokumenter økte med 63%. Det er ikke bare nøyaktighet - det er troverdighet.

En bruker på Reddit, «DataEngineer42», rapporterte en 22% redusert mengde «hallusinasjoner» - altså svar som virker rimelige, men er fullstendig feil - etter å ha lagt til reranking i sitt RAG-system. Det er ikke en liten forbedring. Det er en forskjell mellom å kunne stole på systemet og ikke.

LLM-basert reranking vs. tradisjonelle modeller

Det finnes to hovedgrupper av rerankere: de som bruker store språkmodeller (LLM-er) og de som bruker tradisjonelle cross-encoder-modeller som BGE.LLM-baserte rerankere, som NVIDIA’s nvidia/llama-3.2-nv-rerankqa-1b-v2, er bedre på å forstå komplekse forespørsler. De forstår implisitt kontekst. For eksempel: hvis du spør «Hvor ligger Firth of Forth?», men systemet har et dokument som nevner «Yellowcraig» (en liten by i nærheten), så vil en LLM-forstå at «Firth of Forth» er en fjord, ikke en by, og vil prioritere dokumentet som forklarer fjorden. En tradisjonell cross-encoder kan misforstå dette - den ser bare at «Yellowcraig» og «Firth of Forth» er nære i tekst.

Men det har en pris: hastighet. En LLM-basert reranker legger til omtrent 0,9 sekunder ekstra for hver forespørsel (P50-latens), ifølge Fin AI. Det er ikke mye - men i et system som skal svare i under ett sekund, er det merkbar. Cross-encoder-modeller som BGE er raskere - ofte 3-5 ganger raskere - men de gir dårligere nøyaktighet i komplekse tilfeller.

Det er derfor mange selskaper nå bygger egne, «lærte» rerankere. De bruker en LLM som «lærer» - den vurderer dokumenter og gir score. Deretter trener de en mindre, raskere modell til å gjøre det samme - men med bare 0,2 sekunders forsinkelse. Denne modellen oppnår 95% av kvaliteten til den store LLM-en. Det er som å ta en ekspert og trene en nyansert assistent til å tenke som ham - men raskere og billigere.

Hvordan bruker bedrifter reranking i praksis?

Reranking er ikke lenger en eksperimentell teknikk. Ifølge Gartner, brukte 68% av enterprise-RAG-systemer reranking i fjerde kvartal 2023 - opp fra bare 22% i midten av 2022. Det er en voldsom økning.De mest brukte sektorene er:

- Kundesupport (78% av implementeringer)

- Teknisk dokumentasjon (63%)

- Finansiell tjenesteyting (52%)

I kundesupport betyr det at kunder får riktig svar første gang - og trenger ikke å ringe opp. I finans betyr det at regler og prosedyrer blir forstått riktig - og at det ikke skjer feil i risikovurderinger. I teknisk dokumentasjon betyr det at ingeniører ikke må søke i ti dokumenter for å finne den ene som faktisk løser problemet.

En bedrift i Pinecone-kommunen rapporterte en 41% økning i første-kontakt-løsningsrate etter å ha lagt til reranking i sin chatbot. Det er ikke bare teknisk - det er økonomisk. Mindre supportanrop. Mindre feil. Mer tillit.

Hva må du vite for å implementere det?

Hvis du vil prøve det selv, her er hva du trenger:- En RAG-pipeline - du må ha et system som henter dokumenter først (med vektorsearch).

- En reranker-modell - du kan bruke en ferdig modell som NVIDIA’s NeMo Retriever, eller en open-source cross-encoder som BGE.

- Python og transformer-bibliotek - det er standardverktøy for å integrere modeller.

- GPU med minst 16 GB VRAM - hvis du bruker LLM-basert reranking. En A100-gpu klarer 12-15 forespørsler per sekund.

For å starte med punktvise reranking, kan du bruke en enkel prompt som denne:

«Du er en ekspert i å vurdere relevans. Her er en kundespørsmål: [spørsmål]. Her er et dokument fra hjelpesenteret: [dokument]. Vurder hvor godt dette dokumentet svarer på spørsmålet. Gi en score fra 1 til 10. Skriv kun tallet.»

Denne metoden er enkel å teste. Men for å få maksimal kvalitet, må du finne ut hva som fungerer for din type data og forespørsler. Det krever testing, måling og iterasjon.

Hva er fremtiden for reranking?

Fremtiden går mot smartere, raskere og mer tilpassede løsninger. NVIDIA har allerede annonsert en ny versjon av NeMo Retriever med 30% lavere latens - uten tap i kvalitet. Universitetet i Washington har vist at det er mulig å justere antall dokumenter som blir reranket basert på spørsmålets kompleksitet - for eksempel: hvis spørsmålet er enkelt («Hva er åpningstidene?»), så reranker du bare de tre beste. Hvis det er komplekst («Sammenlign skatteordninger for selvstendige i Norge, Sverige og Danmark»), så går du gjennom alle ti. Det kan redusere gjennomsnittlig forsinkelse med 40% uten å tape kvalitet.Forrester forutser at 85% av enterprise-RAG-systemer i 2025 vil bruke minst én LLM-basert reranker. Det er ikke lenger en valgfri forbedring - det er en standard. Det er som å ha en kvalitetskontroll i en fabrikk. Du kan produsere produkter uten den - men du vil ikke ha kunder som tror på dem.

Hva er utfordringene?

Det er ikke alltid enkelt. Noen av de vanligste problemene er:- Prompt-innretning: Det er vanskelig å skrive prompter som gir konsekvent score. Det er mange åpne issues i LangChain om dette.

- Minnebruk: Når du reranker mange dokumenter samtidig, kan du få minneproblemer - spesielt med store LLM-er.

- Latens: 0,9 sekunder kan være for mye i sanntidssystemer.

- Måling: Det finnes ingen enkelt standard for å måle reranking-kvalitet. De fleste bruker NDCG, MRR og Recall - men det er ikke alltid enig i hvilken som er viktigst.

Det beste rådet? Start smått. Test med en enkel punktvis reranker på 5 dokumenter. Se om svarene blir bedre. Mål forskjellen. Hvis du ser en klar forbedring, utvid. Ikke prøv å bygge en perfekt løsning fra starten. Prøv, mål, forbedre - det er den eneste veien.

Hva er forskjellen mellom vektorsearch og reranking?

Vektorsearch finner dokumenter som er semantisk nærme spørsmålet - men det gjør det ikke perfekt. Den kan hente inn dokumenter som inneholder riktige ord, men ikke den riktige meningen. Reranking tar de resultatene og sorterer dem på nytt - basert på hvor godt de faktisk svarer på spørsmålet. Det er som å bruke en søkemotor for å finne 10 nettsteder, og så la en ekspert velge ut de 3 beste for deg.

Er reranking nødvendig for alle RAG-systemer?

Nei - men det er nødvendig for de fleste seriøse systemer. Hvis du bare bygger en demo eller tester med enkle spørsmål, kan du komme utenom det. Men hvis du vil at systemet skal brukes i produksjon - i kundesupport, finans eller teknisk dokumentasjon - så er reranking ikke en bonus. Det er en grunnleggende del av å få nøyaktige, troverdige svar. Uten det, er du bare på vei mot hallucinasjoner og misforståelser.

Hvilken reranker skal jeg velge - LLM eller cross-encoder?

Hvis du trenger maksimal nøyaktighet og kan akseptere litt lengre svarstid (opptil 1 sekund), velg en LLM-basert reranker som NVIDIA’s NeMo Retriever. Hvis du trenger rask respons og spørsmålene dine er enkle (f.eks. «Hva er min konto-status?»), så kan en cross-encoder som BGE være nok. Mange selskaper starter med BGE og bytter til LLM når de ser at kvaliteten ikke er god nok.

Kan jeg bruke reranking uten en LLM?

Ja - og mange gjør det. Cross-encoder-modeller som BGE, Cohere og Sentence-BERT er alle rerankere som ikke bruker store språkmodeller. De er raskere og mindre krevende. De fungerer bra for enkle forespørsler og mindre komplekse data. Men de mangler evnen til å forstå implisitt kontekst - for eksempel at «Firth of Forth» er en fjord, ikke en by. For komplekse spørsmål, er LLM-er bedre.

Hvor mye koster det å implementere reranking?

Det avhenger av hvilken metode du velger. En open-source cross-encoder kan integreres på 2-3 dager og koster ingenting. En LLM-basert reranker krever GPU-ressurser (en A100 koster ca. 1,500 USD per måned i skyen) og kan ta 2-3 uker å optimere. Men den faktiske kostnaden er ikke i teknologi - den er i tapt tid og feil. Et system uten reranking kan koste mer i kundesupport og skade på tilliten til systemet enn det koster å sette opp en god reranker.

Post Comments (10)

lol sånn her er jo bare for folk som tror at AI kan tenke. reranking? hah. det er bare en fancy måte å si at du ikke har god nok data. jeg har sett 100+ RAG-systemer og 98% av dem er bare hallucinasjoner med en liten skikkelig maskinlæringssnøff på toppen. du tror du får nøyaktighet? neida. du får bare mer elegante feil. 🤡

... jeg prøvde det. bare en enkel BGE-reranker. 3 dokumenter. 20 forespørsler. 14 ganger ble svaret bedre. men det var så stressende å vente 0.8 sekunder før svaret kom... jeg tenkte på alle kundene som måtte vente. er det verdt det? jeg vet ikke. men jeg sover bedre når systemet ikke lager feil. 🫠

reranking? hah. det er bare kapitalismens siste dødskamp mot å tenke. du tror du kan 'sortere' sannheten? neida. sannheten er ikke en liste. den er en kvasi-mystisk tilstand som ikke kan reduseres til scores. LLM-er er ikke ekspertene du tror de er. de er bare spiegelbilder av våre egne fordommer. du bygger en temple av tall, men gud er død. 🤔

Det her er en av de raree sakene som virkelig gjør forskjell. Ikke fordi det er magisk, men fordi det er enkle. Start med punktvis reranking på 5 dokumenter. Bruk en gratis modell. Test med 10 spørsmål fra virkeligheten. Mål forskjellen. Hvis du ser at svarene blir mer presise og mindre flau, så utvid. Ikke tenk på perfeksjon. Tenk på forbedring. Det er det som skiller gode systemer fra gode historier. Du trenger ikke å være en AI-forsker. Du trenger bare å prøve. 🙌

hei, jeg prøvde det med en liten prompt: «gi score 1-10» og det var som en hel ny verden. før var det alltid «ja, men...» og så kom det med noe som sa «skatt i 2023» når jeg spurte om 2026. nå får jeg faktisk det jeg spør etter. det er ikke perfekt, men det er så mye bedre. jeg tror det er som å ha en kameramann som holder kameraet på riktig person i stedet for å fokusere på bakgrunnen. 🤓

Det er viktig å understreke at reranking ikke er en teknisk kuriositet, men en etisk nødvendighet i systemer som påvirker kundeservice og finansiell beslutningstaking. Uten kontroll over relevans og presisjon, risikerer vi å forsterke misinformasjon på systemnivå. Det er ikke bare en spørsmål om ytelse - det er et spørsmål om ansvar. Jeg anbefaler sterkt å dokumentere og validere hver iterasjon med brukerfeedback. Dette er ikke bare kode. Det er påvirkning.

hei jeg prøvde reranking men jeg skrev feil i prompten og det gikk helt galt 😅 men da jeg retta opp det ble det så mye bedre! jeg tror det er viktig å teste mye og ikke bare tro på at modellen vet hva den gjør. også så er det litt vanskelig å forstå hva NDCG faktisk betyr men jeg tror det er som å måle hvor godt du får riktig svar først. men jeg elsker å prøve nye ting! 🌟

Denne teksten er full av unødvendig fluff og ikke-relevant informasjon. Det er ikke 68% av enterprise-RAG-systemer som bruker reranking - det er en utvendig tall fra en markedsanalyse som ikke er publisert. Det finnes ingen offisiell Gartner-rapport som støtter dette. Videre er det feilaktig å si at LLM-baserte rerankere forstår implisitt kontekst - de forstår ikke noe. De predikerer basert på statistiske mønstre. Dette er pseudovitenskap. En korrekt fremstilling ville ha nevnt at cross-encoders som ColBERT og BERT-v2 er mer robuste og bedre evaluert i peer-reviewed litteratur. Ikke gå etter marketing.

reranking? hah. det er bare en del av det store sammensvergelsen. de vil ha deg til å tro at AI kan tenke, men det er bare en maskin som lurer deg til å tro at du får riktig svar. skatteetaten har ikke publisert noe om 2026. det er bare en fikk. de bruker reranking for å skjule at de ikke har data. du tror du får nøyaktighet? du får en bedre illusion. de vil ha kontroll. de vil ha dine data. det er ikke teknologi. det er kontroll. 🕵️♂️

Det er så rart at folk tror dette er en løsning. Du tror du kan 'sortere' sannheten med en modell? Hva med at alle dokumentene er manipulert? Hva med at skatteetaten har skjult de riktige reglene? Reranking vil bare gi deg det du *tror* du skal ha - ikke det du trenger. Denne teknologien er ikke nøyaktig. Den er *målebar*. Og det er to helt forskjellige ting. Du vil ikke se det før du har mistet alt. 🧠